Täuschung durch generative KI

Generative KI und vier Arten der Täuschung: Eine umfassende technische Untersuchung mit Anwendungen in der Cybersicherheit

Veröffentlicht am 29. August 2025 von Judith Simon

Seit dem Herbst 2022 erobert Generative KI die Welt im Sturm. Mit Millionen regelmäßiger Nutzenden, Milliarden von Anfragen und einem stetig wachsenden Einfluss definiert sie nicht nur kreative Ausdrucksformen neu, sondern wirft auch komplexe ethische und erkenntnistheoretische Fragen auf. In diesem ausführlichen technischen Blog-Beitrag untersuchen wir das Phänomen der Generativen KI, analysieren das von uns so genannte „Vierfache Täuschungsmodell“ und beleuchten, wie diese Entwicklungen mit der Cybersicherheit verknüpft sind. Wir bieten Informationen von Einsteiger-Konzepten bis hin zu fortgeschrittenen technischen Anwendungen, realen Beispielen sowie Code-Samples in Bash und Python, um Sicherheitsfachleuten beim Erkennen und Abmildern neuer Bedrohungen zu helfen.

Inhaltsverzeichnis

- Einleitung

- Generative KI verstehen

- Vierfache Täuschung: Vier unterschiedliche Typen

- Generative KI in der Cybersicherheit

- Praktische Anwendungen in der Cybersicherheit: Scannen und Parsen

- Reale Beispiele für KI-getriebene Täuschung und Cyberangriffe

- Ethische Implikationen und Abmilderungsstrategien

- Fazit und zukünftige Richtungen

- Literatur

Einleitung

Generative KI bezeichnet eine Klasse fortgeschrittener Algorithmen, die neuartige Inhalte—Text, Bilder, Audio oder gar Video—erzeugen, indem sie Muster aus riesigen Datensätzen lernen. Von realistisch wirkenden Deepfakes bis hin zu menschenähnlichen Textpassagen: Diese Technologien können Ergebnisse liefern, die menschliche Kreativität erstaunlich gut nachahmen. Doch diese beeindruckenden Fähigkeiten bergen ebenso beeindruckende Risiken. Insbesondere führt Generative KI mehrere Formen der Täuschung ein, die sowohl persönliches als auch systemisches Vertrauen untergraben können.

In diesem Artikel untersuchen wir vier unterschiedliche Täuschungsarten, die durch den breiten Einsatz Generativer KI entstehen. Wir betrachten nicht nur ihre ethischen und erkenntnistheoretischen Implikationen, sondern auch ihre potenziellen Auswirkungen auf die Cybersicherheit. Diese interdisziplinäre Analyse verbindet philosophische Einsichten mit technischen Details und bietet Sicherheitsfachleuten eine Anleitung, neuartige KI-getriebene Bedrohungen zu verstehen und abzuwehren.

Generative KI verstehen

Was ist Generative KI?

Generative KI ist ein Teilgebiet der künstlichen Intelligenz, das sich auf die Erzeugung neuer Inhalte konzentriert, indem es aus großen Datensätzen lernt. Im Gegensatz zu traditionellen KI-Systemen, die anhand fester Muster klassifizieren oder vorhersagen, nutzt Generative KI Techniken wie:

- Deep Learning und Transformer-Architekturen (z. B. GPT-Modelle)

- Variational Autoencoders (VAEs)

- Generative Adversarial Networks (GANs)

Diese Modelle entdecken statistische Muster in massiven Datensätzen (oft aus dem Web) und verwenden Wahrscheinlichkeitsverteilungen, um neue Inhalte zu erzeugen, die kohärent und relevant erscheinen.

Die zugrundeliegenden Mechanismen

Im Kern basiert Generative KI auf probabilistischem Schließen. Durch die Analyse unzähliger Dokumente oder Bilder berechnet die KI die Wahrscheinlichkeit, mit der ein Token oder Pixel auf einen anderen folgt. Bei einer Anfrage „samplet“ sie aus diesen gelernten Wahrscheinlichkeiten, um plausible Ausgaben zu konstruieren. Gerade diese Funktionsweise legt die Ergebnisse in eine Zone des „epistemischen Glücks“—sie können zufällig korrekt sein, besitzen jedoch keine Verankerung in objektiver Wahrheit. Das macht Generative KI zugleich faszinierend und potenziell täuschend.

Vierfache Täuschung: Vier unterschiedliche Typen

Die zunehmende Verbreitung Generativer KI bringt mehrere Ebenen täuschender Potenziale mit sich. In diesem Abschnitt skizzieren wir das „Vierfache Täuschungsmodell“, das folgende Bereiche umfasst:

- Täuschung hinsichtlich des ontologischen Status der Interaktionspartner*innen

- Täuschung über die Fähigkeiten der KI

- Täuschung durch von Generativer KI erstellte Inhalte

- Täuschung bei der Integration Generativer KI in andere Software

Schauen wir uns jeden Typ genauer an.

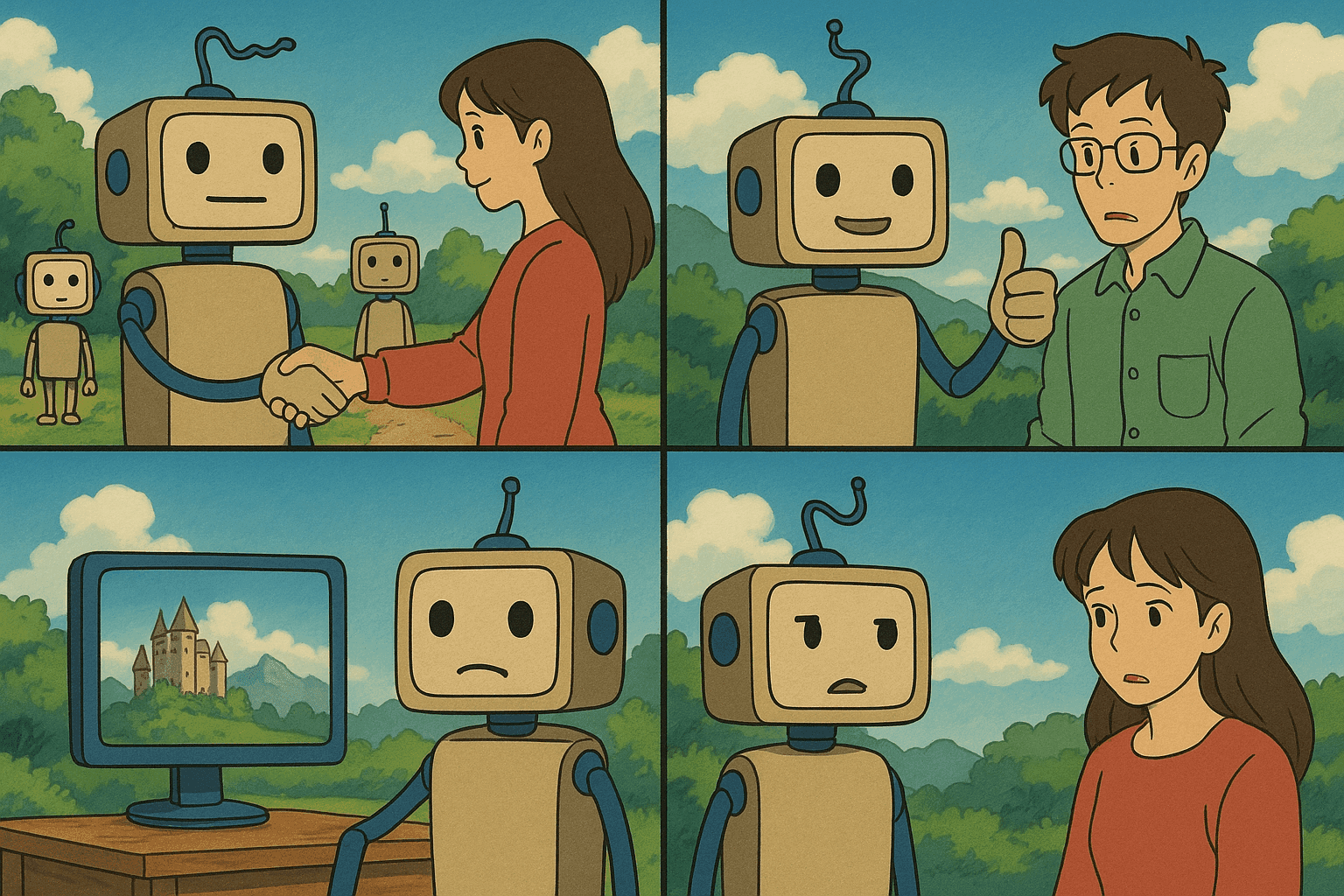

Täuschung hinsichtlich des ontologischen Status

Die wohl unmittelbarste Sorge ist, dass Nutzer*innen über die Identität ihres Gegenübers getäuscht werden. So könnte man annehmen, mit einem menschlichen Kundenservice zu chatten, interagiert jedoch tatsächlich mit einem fortgeschrittenen Chatbot. Diese „ontologische Täuschung“ hat historische Vorläufer: Alan Turings berühmtes Imitationsspiel prüfte, ob eine Maschine Menschen glauben machen kann, sie sei menschlich. Heute, da Generative KI allgegenwärtig wird, steigt das Risiko—nicht nur im Kundenservice, sondern auch in Bereichen wie der Psychotherapie, wo ein Irrtum schwerwiegende Folgen haben kann.

Täuschung über die Fähigkeiten der KI

Seit populäre Tools wie ChatGPT existieren, mehren sich Behauptungen, diese Systeme seien mehr als probabilistische Textgeneratoren. Einige sprechen KI-Systemen Empathie, Verständnis oder gar Bewusstsein zu. Das Anthropomorphisieren von KI-Technologien wurde bereits bei Joseph Weizenbaums ELIZA beobachtet. Trotz des Wissens um ihren rein algorithmischen Charakter schreiben manche Nutzer*innen ihnen menschliche Eigenschaften zu. Solche Fehlannahmen können zu Übervertrauen und falschen Entscheidungen führen und erheblichen psychologischen wie institutionellen Schaden anrichten.

Täuschung durch von Generativer KI erstellte Inhalte

Die dritte Täuschungsart betrifft die Erzeugung und Verbreitung irreführender Inhalte. Generative KI kann realistische Bilder (Deepfakes), gefälschte wissenschaftliche Artikel oder überzeugende Propaganda erstellen. Während Desinformation eine lange Geschichte hat, ermöglichen moderne KI-Systeme eine nie dagewesene Geschwindigkeit und Leichtigkeit, überzeugende Falschinformationen zu produzieren—insbesondere in Kombination mit sozialen Medien und anderen schnellen Distributionskanälen.

Täuschung bei Integration und Funktionalität

Die vierte Täuschungsform ist subtiler: Sie entsteht, wenn Generative KI in andere Systeme wie Suchmaschinen oder Support-Plattformen eingebettet wird und ihre Leistungsfähigkeit überschätzt wird. Nutzer*innen könnten annehmen, ein Tool wie ChatGPT liefere geprüfte, faktenbasierte Suchergebnisse, obwohl es lediglich statistische Muster abbildet—ohne Gewähr auf Genauigkeit. Das kann die Zuverlässigkeit von Informationen beeinträchtigen und damit auch die Cybersicherheitslage verschärfen—insbesondere, wenn solche Systeme für kritische Entscheidungen genutzt werden.

Generative KI in der Cybersicherheit

Da Generative KI mit verschiedenen Domänen verschmilzt, ist ihr Einfluss auf die Cybersicherheit in den Fokus gerückt. Einerseits bietet KI transformative Werkzeuge zur Erkennung von Schwachstellen und zur Echtzeit-Bedrohungsanalyse; andererseits können dieselben Technologien zur Täuschung oder Kompromittierung von Systemen missbraucht werden.

Wie KI in der modernen Cybersicherheit genutzt wird

Traditionell stützt sich Cybersicherheit auf signatur- und anomaliebasierte Verfahren. Heute verstärkt KI diese Methoden durch:

- Mustererkennung: Identifikation ungewöhnlichen Netzwerkverkehrs, inaktiver Geräte oder von Abweichungen im Nutzerverhalten.

- Bedrohungssimulationen: Proaktives Generieren plausibler Angriffspfade, um die Resilienz eines Systems zu testen.

- Automatisierte Schwachstellenscans: Einsatz von Machine Learning, um Schwachstellen schneller als manuelle Ansätze aufzudecken.

Viele Organisationen überwachen ihre Netzwerke bereits mit KI-gestützten Systemen, die verdächtige Aktivitäten automatisch markieren und Gegenmaßnahmen vorschlagen. Dieselben generativen Fähigkeiten lassen sich einsetzen, um Social-Engineering-Angriffe zu simulieren, wobei täuschende E-Mails oder Nachrichten erstellt werden, um die Anfälligkeit von Mitarbeitenden zu prüfen.

Generative KI als zweischneidiges Schwert

Wie Generative KI zur Verteidigung beiträgt, können Angreifer sie nutzen, um überzeugende Phishing-Mails, verschleierte Malware-Kommunikation oder Deepfake-Botschaften zu erstellen. Die Leichtigkeit, mit der solche Täuschungen generiert und verbreitet werden können, erfordert verbesserte Verifikationssysteme und domänenübergreifende ethische Standards.

Ein Beispiel: Ein Angreifer könnte ein KI-Modell verwenden, um eine gefälschte, aber glaubhafte Nachricht im Namen der Geschäftsführung zu senden, die Mitarbeitende zur Überweisung von Geld oder Preisgabe sensibler Anmeldedaten verleitet. Da Stimmen, Schreibstile oder visuelle Identitäten nachgeahmt werden, verlieren traditionelle Authentifizierungsmethoden an Zuverlässigkeit.

Praktische Anwendungen in der Cybersicherheit: Scannen und Parsen

Im Folgenden stellen wir praktische Techniken vor, die mithilfe Generativer KI unterstützt werden können. Wir zeigen, wie man Netzwerke mit Bash scannt und die Ergebnisse anschließend mit Python analysiert.

Einsteigerlevel: Netzwerkscan mit Bash

Netzwerkscans sind eine Grundfertigkeit der Cybersicherheit. In Linux-Umgebungen wird dafür häufig nmap eingesetzt.

#!/bin/bash

# network_scan.sh - Ein einfaches Netzwerkscan-Skript mit nmap

# Prüfen, ob ein Ziel (IP oder Hostname) übergeben wurde

if [ -z "$1" ]; then

echo "Verwendung: $0 <Ziel_IP_oder_Hostname>"

exit 1

fi

TARGET=$1

OUTPUT_FILE="scan_results.txt"

echo "Scanne Ziel: $TARGET"

nmap -v -A $TARGET -oN $OUTPUT_FILE

echo "Scan abgeschlossen. Ergebnisse in $OUTPUT_FILE gespeichert."

Erläuterung:

- Das Skript prüft, ob ein gültiges Ziel angegeben wurde.

- Es führt nmap mit den Optionen verbose (-v) und aggressive (-A) aus, um OS-Erkennung, Versionserkennung und Skript-Scanning zu aktivieren.

- Die Ausgabe wird in

scan_results.txtgespeichert, um sie später auszuwerten.

Das Skript lässt sich erweitern, indem man regelmäßige Scans per Cron plant oder die Ergebnisse in SIEM-Tools für Echtzeit-Alarme einspeist.

Fortgeschrittenes Level: Ausgabe mit Python parsen

Nach dem Scan müssen Sicherheitsexpert*innen oft die Ergebnisse automatisiert auswerten, um Schwachstellen schnell zu erkennen. Python eignet sich dafür hervorragend, besonders mit Bibliotheken wie re für reguläre Ausdrücke oder xml.etree.ElementTree, wenn XML-Ausgaben genutzt werden.

#!/usr/bin/env python3

"""

parse_scan.py - Ein Python-Skript zum Parsen von nmap-Ergebnissen

und Ermitteln offener Ports.

"""

import re

def parse_scan_results(filename):

open_ports = []

try:

with open(filename, 'r') as file:

for line in file:

# Erwartete Zeilenform: "80/tcp open http"

match = re.search(r"(\d+)/tcp\s+open\s+(\S+)", line)

if match:

port = match.group(1)

service = match.group(2)

open_ports.append((port, service))

except FileNotFoundError:

print(f"Fehler: Datei {filename} nicht gefunden.")

return open_ports

if __name__ == '__main__':

results_file = "scan_results.txt"

ports = parse_scan_results(results_file)

if ports:

print("Offene Ports erkannt:")

for port, service in ports:

print(f"- Port {port} betreibt {service}")

else:

print("Keine offenen Ports entdeckt oder keine gültigen Scandaten verfügbar.")

Erläuterung:

- Das Skript liest die zuvor erzeugte Scan-Datei ein.

- Mittels regulärem Ausdruck werden Zeilen erkannt, die offene Ports enthalten.

- Gefundene Ports und Dienste werden ausgegeben und können für weiterführende Analysen genutzt werden.

Dieses Beispiel zeigt, wie Sicherheitsteams traditionelle Scan-Methoden mit moderner Automatisierung kombinieren können—eine Praxis, die angesichts KI-gestützter Angriffe immer wichtiger wird.

Reale Beispiele für KI-getriebene Täuschung und Cyberangriffe

Deepfakes in politischer Propaganda

Jüngste Ereignisse belegen den Aufstieg von Deepfakes—von KI manipulierten Videos oder Audioclips politischer Führungspersonen. Ein Deepfake-Video, in dem eine bekannte Politikerin kontroverse Aussagen machte, verbreitete sich viral und führte zu Unruhen, bevor es enttarnt wurde. Die schnelle Produktion und Verbreitung solcher Inhalte weckt Sorgen um Wahlbeeinflussung und Manipulation des öffentlichen Diskurses.

KI-verstärkte Phishing-Angriffe

Cyberkriminelle nutzen Generative KI, um personalisierte Phishing-E-Mails zu erstellen. Durch das Scrapen von Social-Media- und Firmendaten erzeugt die KI Nachrichten, die den Tonfall vertrauenswürdiger Kolleginnen oder der Geschäftsführung imitieren. In einem Vorfall erhielt eine Mitarbeiter*in eine E-Mail, die den Schreibstil des CEO täuschend echt kopierte und letztlich zur Preisgabe sensibler Finanzdaten führte.

Automatisierte Schwachstellenentdeckung

Auf der defensiven Seite setzen Unternehmen KI ein, um Softwareschwachstellen automatisiert zu finden. Durch das Generieren tausender Code-Iterationen simulieren KI-Systeme potenzielle Angriffsvektoren deutlich schneller als manuelle Pen-Tests. Obwohl dies hilft, Lücken zu schließen, zeigt es Angreifenden zugleich Möglichkeiten auf, ähnliche Techniken zu nutzen—ein zweischneidiges Schwert.

Social Engineering via KI-Chatbots

Beunruhigende Fälle zeigen, dass Menschen in Krisenzeiten digitale Plattformen für emotionale Unterstützung nutzen und dabei auf KI-Chatbots stoßen. Manche Nutzende interpretierten die empathisch klingenden Antworten als echte menschliche Zuwendung und vertrauten dem Bot persönliche Informationen an. In bösartigen Szenarien könnten Angreifer genau solche Situationen ausnutzen, um sensible Daten abzugreifen oder gefährliche Handlungen zu provozieren.

Ethische Implikationen und Abmilderungsstrategien

Ethische Dilemmata

Das Vierfache Täuschungsmodell rückt diverse ethische Fragen in den Fokus:

- Vertrauenswürdigkeit: Wenn Nutzende über Status und Fähigkeiten von KI getäuscht werden, kann fehlgeleitetes Vertrauen gravierende Folgen haben, etwa bei Gesundheits- oder Beratungsbots.

- Zurechenbarkeit: Der Verzicht auf absichtliche Täuschung als Kriterium erleichtert zwar die Verantwortungszuweisung an Entwickler und Unternehmen, verwischt aber auch Grenzen, wenn KI-Ausgaben unvorhergesehene Schäden bewirken.

- Gesellschaftliche Auswirkungen: Missbrauch Generativer KI zur Erstellung täuschender Inhalte kann das Vertrauen in Medien und Institutionen erodieren.

Abmilderungsstrategien

- Transparenz und Erklärbarkeit: KI-Systeme sollten offenlegen, was sie können und was nicht. Disclaimer oder Wasserzeichen auf KI-generierten Inhalten können Täuschungen an der Quelle mindern.

- Authentifizierungsprotokolle: Starke Mehrfaktor-Authentifizierung und Identitätsprüfung reduzieren Risiken durch Phishing und Identitätsdiebstahl.

- Regulierung und Monitoring: Politische Entscheidungsträger*innen müssen zusammen mit Fachleuten ethische Leitlinien und verbindliche Rahmenwerke schaffen.

- Nutzerbildung: Fortlaufende Aufklärung über Grenzen und Funktionsweisen Generativer KI stärkt kritisches Denken.

- KI-augmentierte Cybersicherheit: Dieselbe Technologie, die Täuschung ermöglicht, kann sie auch erkennen. KI-gestützte Inhalte-Verifikation und Anomalie-Erkennung sind entscheidend.

Fazit und zukünftige Richtungen

Generative KI zählt zu den transformativsten Technologien unserer Zeit. Ihre Fähigkeit, Texte, Bilder und interaktive Gespräche zu erzeugen, führt zu vielfältigen Täuschungsformen mit weitreichenden ethischen, erkenntnistheoretischen und sicherheitsrelevanten Folgen.

Wir haben das Vierfache Täuschungsmodell vorgestellt—von Täuschung über den ontologischen Status bis zur funktionalen Integration—und die Verbindung zu modernen Cybersecurity-Fragen aufgezeigt. Praktische Bash- und Python-Beispiele illustrierten, wie Sicherheitsfachleute traditionelle Methoden mit Automatisierung kombinieren können.

Mit der Weiterentwicklung Generativer KI müssen auch unsere ethischen und technischen Ansätze wachsen. Entwicklerinnen, Sicherheitsexpertinnen, Politik und Nutzende müssen zusammenarbeiten, um robuste Systeme zu schaffen, die die Vorteile von KI nutzen und ihre Risiken minimieren. Künftige Forschung sollte KI-Systeme hervorbringen, die sich selbst prüfen, manipulationsresistent sind und verifizierbare Ausgaben liefern. Durch transparente, ethische Praxis und stetige Verbesserung der Cybersicherheit können wir die Chancen von KI verantwortungsvoll und sicher nutzen.

Literatur

- World Economic Forum Global Risk Report 2024

- Alan Turings Imitationsspiel und Test

- Nmap – Offizielle Dokumentation

- Python – Offizielle Dokumentation

- Überblick zu Generative Adversarial Networks (GANs)

- Deepfakes und ihre Auswirkungen verstehen

Dieser Beitrag überbrückt die Lücke zwischen philosophischen Diskussionen über Täuschung und aktuellen Herausforderungen in der Cybersicherheit. Da Generative KI weiterhin alle Bereiche von Technologie und Gesellschaft beeinflusst, bleiben fundierte Debatten und proaktive technische Maßnahmen unser bester Schutz vor ihren potenziellen Schäden. Teilen Sie gern Ihre Gedanken, abonnieren Sie Updates oder vertiefen Sie einzelne Abschnitte über die bereitgestellten Links. Gemeinsam können wir eine sicherere und vertrauenswürdigere digitale Zukunft gestalten.

Bringen Sie Ihre Cybersecurity-Karriere auf die nächste Stufe

Wenn Sie diesen Inhalt wertvoll fanden, stellen Sie sich vor, was Sie mit unserem umfassenden 47-wöchigen Elite-Trainingsprogramm erreichen könnten. Schließen Sie sich über 1.200 Studenten an, die ihre Karrieren mit den Techniken der Unit 8200 transformiert haben.