Untitled Post

# Nightshade: Ein revolutionäres Data-Poisoning-Tool im Kampf gegen Generative KI

*Veröffentlicht in der [MIT Technology Review](https://www.technologyreview.com/) und inspiriert von bahnbrechender Forschung, ist Nightshade ein neues Data-Poisoning-Tool, das Künstler*innen, Forscher*innen und Cybersecurity-Fachleute dabei unterstützt, den Missbrauch kreativer Werke in generativen KI-Modellen zu verstehen und zu bekämpfen.*

In der heutigen digitalen Ära stehen generative KI-Modelle wie DALL-E, Midjourney und Stable Diffusion an der Spitze der Innovation. Diese Modelle werden jedoch mit riesigen Datenmengen aus dem Internet trainiert – darunter häufig Kunstwerke talentierter Künstler*innen, die ohne deren Zustimmung verwendet werden. Diese unautorisierte Nutzung hat hitzige Debatten über Urheberrechte, Dateneigentum und die ethischen Implikationen von KI-Trainingspraktiken ausgelöst. Als Reaktion darauf haben Forschende Werkzeuge wie Nightshade entwickelt, mit denen Künstler*innen ihre Bilder „vergiften“ können, bevor sie Teil solcher Trainingsdatensätze werden. Dieser ausführliche technische Blogpost beleuchtet Nightshade im Detail, geht auf die zugrunde liegende Technologie, die Cybersecurity-Aspekte sowie praxisnahe Beispiele mit Code ein und hilft so Einsteiger*innen wie Fortgeschrittenen, diesen innovativen Ansatz zu verstehen.

---

## Inhaltsverzeichnis

1. [Einführung](#einführung)

2. [Generative KI, Urheberrecht und der Bedarf an Datenschutz](#generative-ki-urheberrecht-und-der-bedarf-an-datenschutz)

3. [Data Poisoning verstehen](#data-poisoning-verstehen)

4. [Funktionsweise von Nightshade](#funktionsweise-von-nightshade)

5. [Technische Umsetzung Nightshade-ähnlicher Verfahren](#technische-umsetzung-nightshade-ähnlicher-verfahren)

- [Bild-Perturbationstechniken](#bild-perturbationstechniken)

- [Codebeispiel: Python-Implementierung für Pixel-Perturbation](#codebeispiel-python-implementierung-für-pixel-perturbation)

6. [Cybersecurity-Perspektive auf Data Poisoning in KI](#cybersecurity-perspektive-auf-data-poisoning-in-ki)

- [Scannen und Protokollieren vergifteter Datenproben](#scannen-und-protokollieren-vergifteter-datenproben)

- [Codebeispiel: Bash-Skript zum Scannen nach anomaler Metadaten](#codebeispiel-bash-skript-zum-scannen-nach-anomaler-metadaten)

7. [Praxisbeispiele und Anwendungsfälle](#praxisbeispiele-und-anwendungsfälle)

8. [Rechtliche und ethische Implikationen](#rechtliche-und-ethische-implikationen)

9. [Zukünftige Richtungen in Datensicherheit und KI](#zukünftige-richtungen-in-datensicherheit-und-ki)

10. [Fazit](#fazit)

11. [Literaturverzeichnis](#literaturverzeichnis)

---

## Einführung

Generative KI hat die Welt im Sturm erobert: Sie kann realistische Bilder, Kunstwerke und sogar Textinhalte anhand von Prompts erzeugen. Doch bei aller technologischen Bedeutung gibt es Herausforderungen. Ein Hauptproblem für die Kunstszene ist, dass KI-Unternehmen Millionen – sogar Milliarden – von Bildern aus dem Internet abgreifen, um ihre Modelle zu trainieren. Künstler*innen entdecken ihre Werke häufig ohne Erlaubnis im Trainingsmaterial, was eine Debatte über Urheberrecht und geistiges Eigentum entfacht.

Nightshade bietet einen proaktiven Ansatz, indem es Künstler*innen ermöglicht, ihre Bilder subtil zu „vergiften“. Gelangen diese Bilder in Trainingsdatensätze, führen die leichten Störungen dazu, dass generative KI-Modelle die Daten falsch interpretieren und unerwartete, oft chaotische Ergebnisse liefern. In diesem Blogpost beleuchten wir die technischen und sicherheitsrelevanten Aspekte dieser Innovation, erklären Funktionsweise und Nutzen und stellen die zugrunde liegende Technologie vor.

---

## Generative KI, Urheberrecht und der Bedarf an Datenschutz

### Der Aufstieg generativer KI

Generative KI-Systeme haben die Kreativbranchen revolutioniert. Durch das Lernen an riesigen Datensätzen können sie Bilder generieren, Geschichten schreiben, Musik komponieren und vieles mehr. Ihre Raffinesse ergibt sich maßgeblich aus der Datenmenge, auf der sie trainiert werden. Diese Daten werden jedoch oft ohne explizite Zustimmung der Ursprungsschaffenden gesammelt.

### Urheberrechtsprobleme für Künstler*innen

Für viele Kunstschaffende bedeutet die unautorisierte Nutzung ihrer Werke nicht nur einen Urheberrechtsverstoß, sondern auch einen Verlust kreativer Kontrolle. Da die Branche rasant in Richtung immer größerer Modelle tendiert, die enorme Datenmengen verschlingen, entsteht ein Machtungleichgewicht zwischen großen Tech-Konzernen und Einzelkünstler*innen. Diese Situation motiviert die Forschung, Methoden zu entwickeln, die den Schaffenden Kontrolle zurückgeben.

### Bedarf an Datenschutz und geistigen Eigentumsrechten

Data-Poisoning-Tools wie Nightshade beantworten diesen Bedarf. Durch subtile, fast unsichtbare Veränderungen am Bildmaterial fungieren sie als digitale „Stolperdrähte“, die den Trainingsprozess von KI-Modellen stören. Das entmutigt nicht nur unautorisiertes Scraping, sondern fördert auch eine Diskussion über verantwortungsvolle KI-Entwicklung und Datenethik.

---

## Data Poisoning verstehen

Data Poisoning ist ein häufig in der Cybersecurity diskutiertes Konzept: Dabei wird Trainingsdaten manipuliert, um zu verfälschen, wie Machine-Learning-Modelle daraus lernen. Historisch war Data Poisoning eher als Angriffstechnik bekannt; Nightshade hingegen versteht sich als Verteidigungsstrategie von Kreativen zum Schutz ihres geistigen Eigentums.

### Was ist Data Poisoning?

Beim Data Poisoning werden Anomalien in den Trainingsdaten verankert, die das Lernverfahren in die Irre führen. Wird diese Methode gezielt von Künstler*innen eingesetzt, kann sie KI-Modelle, die stark von solchen Datensätzen abhängen, untergraben, ohne dabei die menschliche Wahrnehmung des Kunstwerks zu beeinträchtigen.

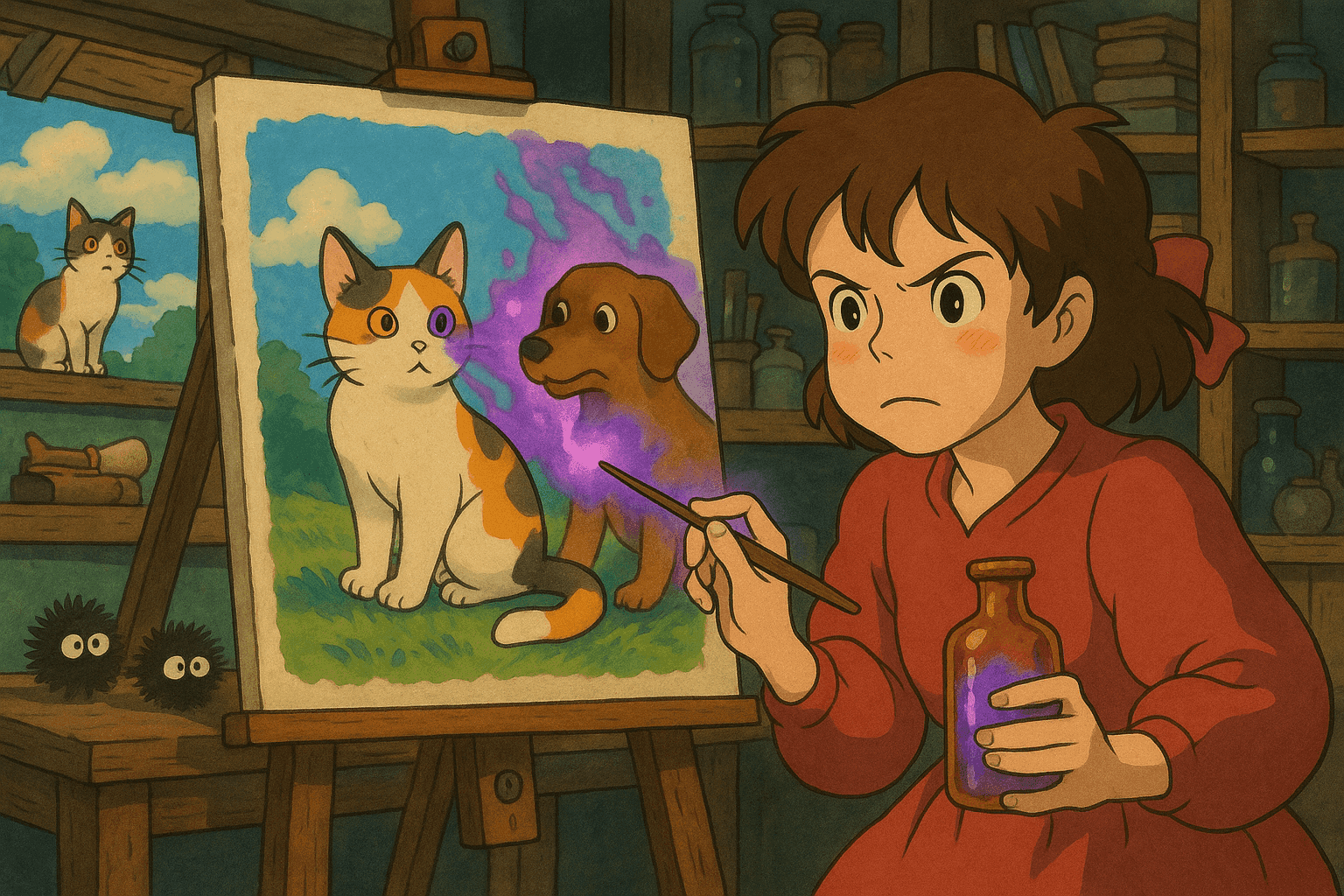

### Mechanismen der Vergiftung

Stellen wir uns vor, ein KI-Modell wird auf Hundebilder trainiert. Ein vergiftetes Bild könnte subtile Pixel-Störungen oder leicht veränderte Muster einführen, sodass der Algorithmus eine falsche Zuordnung erlernt und „Hund“ allmählich wie „Katze“ aussieht. Je mehr vergiftete Bilder aufgenommen werden, desto stärker verbreitet sich diese Fehlinterpretation – Hunde werden zu seltsamen Mischwesen oder verwandten Fehlklassifikationen.

Diese Technik unterscheidet sich von klassischen adversarialen Beispielen, da die Vergiftung in der Sammelphase der Daten erfolgt, nicht beim späteren Inferenzinput.

---

## Funktionsweise von Nightshade

Nightshade nutzt fortgeschrittene Data-Poisoning-Techniken, um generative KI dazu zu bewegen, Urheberrecht und kreative Integrität zu respektieren.

### Der Prozess

1. **Bildmodifikation**

Beim Hochladen eines Bildes verändert Nightshade die Pixeldaten auf subtile Weise. Diese Änderungen sind für das menschliche Auge nicht erkennbar, haben jedoch großen Einfluss auf algorithmische Interpretationen.

2. **Unsichtbare Perturbationen**

Durch imperzeptible Störungen in unterschiedlichen Bildbereichen stellt Nightshade sicher, dass die Modifikationen vor Betrachter*innen verborgen bleiben, während sie während des Trainings Fehler auslösen.

3. **Störung des KI-Trainings**

Werden diese vergifteten Bilder von KI-Systemen gesammelt, entstehen während des Trainings falsche Assoziationen. Das kann zu bizarren Ausgaben führen – Hunde ähneln Katzen, Landschaften erscheinen surreal, thematische Verwirrung greift um sich.

### Integration mit Glaze

Nightshade ist kein Einzeltool, sondern wird mit Glaze kombiniert. Während Nightshade die Daten vergiftet, maskiert Glaze den Stil einer/s Künstler*in, sodass die einzigartige kreative Signatur beim Online-Upload erhalten bleibt. Gemeinsam geben die Tools Kreativen die Möglichkeit, ihr geistiges Eigentum zu schützen und sich gegen unautorisierte Nutzung zu wehren.

### Open-Source-Vorteil

Ein spannender Aspekt von Nightshade ist seine Open-Source-Natur. Das demokratisiert die Technologie, fördert Zusammenarbeit und sorgt für robuste Weiterentwicklung – sowohl für bessere Verteidigung als auch für das Erkennen von Data Poisoning in Gegenangriffen.

---

## Technische Umsetzung Nightshade-ähnlicher Verfahren

Die exakten Implementierungsdetails von Nightshade befinden sich zwar noch im Peer Review, wir können jedoch ähnliche Techniken mittels Bild-Perturbationsbibliotheken in Python demonstrieren.

### Bild-Perturbationstechniken

1. **Pixelgenaue Rauschinjektion**

Mit Pillow und NumPy lässt sich geringes Rauschen hinzufügen. Diese Änderungen liegen meist unterhalb der Wahrnehmungsschwelle für Menschen, beeinflussen jedoch die Feature-Erkennung durch KI-Modelle.

2. **Filterung im Frequenzbereich**

Mittels Fourier-Transformationen können Frequenzkomponenten eines Bildes manipuliert werden. Kleine Anpassungen in bestimmten Frequenzbereichen – nach Rücktransformation unsichtbar – können als effektive Vergiftungsmarker dienen.

3. **Stil-Transfer-Kontamination**

Durch dezente Beimischung eines Zweitstils kann die Stilerkennung eines Datensatzes verfälscht werden. Der Inhalt bleibt erkennbar, doch die subtilen Stilvariationen verwirren KI-Modelle.

### Codebeispiel: Python-Implementierung für Pixel-Perturbation

```python

import numpy as np

from PIL import Image, ImageEnhance

def add_subtle_noise(image_path, output_path, noise_level=5):

"""

Fügt einem Bild leichtes, zufälliges Rauschen hinzu.

Parameter:

- image_path (str): Pfad zum Eingabebild

- output_path (str): Pfad zum Speichern des vergifteten Bildes

- noise_level (int): Intensität des Rauschens

"""

image = Image.open(image_path).convert('RGB')

image_arr = np.array(image)

noise = np.random.randint(-noise_level, noise_level, image_arr.shape, dtype='int16')

poisoned_arr = image_arr.astype('int16') + noise

poisoned_arr = np.clip(poisoned_arr, 0, 255).astype('uint8')

poisoned_image = Image.fromarray(poisoned_arr)

enhancer = ImageEnhance.Contrast(poisoned_image)

poisoned_image = enhancer.enhance(1.0)

poisoned_image.save(output_path)

print(f"Vergiftetes Bild gespeichert unter {output_path}")

if __name__ == "__main__":

add_subtle_noise("original_art.jpg", "poisoned_art.jpg")

Cybersecurity-Perspektive auf Data Poisoning in KI

Data Poisoning ist ein zweischneidiges Schwert. Klassischerweise dient es Angreifenden dazu, KI-Systeme zu sabotieren. Mit Nightshade verschiebt sich die Erzählung: Künstlerinnen und Rechteinhaberinnen nutzen es defensiv, um ihre Werke zu schützen.

Bedrohungslandschaft

AI-Modelle, die auf gescrapten Daten basieren, stellen eine dynamische Angriffsfläche dar. Schon wenige vergiftete Bilder können die Fähigkeit eines generativen Modells, Prompts korrekt zu interpretieren, erheblich verschlechtern.

Scannen und Protokollieren vergifteter Datenproben

Vergiftete Daten aufzuspüren erfordert Monitoring und Analyse der Trainingsdatensätze. Automatisierte Skripte prüfen Metadaten, Pixelverteilungen und Frequenzinformationen, um verdächtige Bilder zu kennzeichnen.

Codebeispiel: Bash-Skript zum Scannen nach anomaler Metadaten

#!/bin/bash

# Verzeichnis auf anomale Bilddateien prüfen

IMAGE_DIR="./images"

EXPECTED_MIN_SIZE=50000

EXPECTED_MAX_SIZE=5000000

echo "Scanne Verzeichnis: $IMAGE_DIR ..."

for image in "$IMAGE_DIR"/*.{jpg,png,jpeg}; do

if [ -f "$image" ]; then

FILE_SIZE=$(stat -c%s "$image")

CREATION_DATE=$(stat -c%y "$image")

if [ $FILE_SIZE -lt $EXPECTED_MIN_SIZE ] || [ $FILE_SIZE -gt $EXPECTED_MAX_SIZE ]; then

echo "Anomalie entdeckt: $image"

echo " Größe: $FILE_SIZE Bytes, Erzeugt: $CREATION_DATE"

fi

fi

done

echo "Scan abgeschlossen."

Praxisbeispiele und Anwendungsfälle

Beispiel 1: Störung eines Hundebild-Generators

In Experimenten führten Forschende nur 50 vergiftete Hundebilder in den Trainingsdatensatz eines generativen Modells ein. Bei späteren Prompts zeigten die generierten Hunde verzerrte Gesichter, zusätzliche Gliedmaßen oder cartoonhafte Merkmale. Mit etwa 300 vergifteten Proben verwandelten sich Hunde teilweise in katzenähnliche Wesen.

Beispiel 2: Verhindern unautorisierten Kunst-Scrapings

Mit Nightshade + Glaze können Künstler*innen ihre Landschaftskunst mit unsichtbaren „Fingerabdrücken“ versehen. Werden diese Bilder gescrapet, lernt das Modell falsche Assoziationen zu Naturmotiven und liefert fehlerhafte Outputs.

Beispiel 3: Cybersecurity jenseits des Kunstschutzes

Das Prinzip ist auch für andere Bereiche relevant: autonome Fahrzeuge, Spam-Erkennung oder Finanzbetrug. Durch das Verständnis subtiler Manipulationen können Sicherheitsteams bessere Abwehrmechanismen entwickeln.

Rechtliche und ethische Implikationen

Rechte der Künstler*innen

Nightshade wirkt als Abschreckung gegen unautorisiertes Scraping und unterstreicht die Forderung nach fairer Vergütung und Attribution.

Dual-Use-Dilemma

Wie viele Sicherheitswerkzeuge kann Data Poisoning auch missbraucht werden. Angreifende könnten kritische KI-Systeme sabotieren. Daher braucht es Richtlinien und Gegenmaßnahmen.

Ethische Verantwortung in der KI-Entwicklung

Die Forschung zu Nightshade betont eine verantwortungsvolle KI. Entwickler*innen müssen Innovation mit Verantwortung abwägen und auf ethisch gewonnene Daten achten.

Zukünftige Richtungen in Datensicherheit und KI

- Robustheitsforschung – adversariales Training, robuste Optimierung und Anomalieerkennung.

- Open-Source-Zusammenarbeit – Community-Feedback macht Tools widerstandsfähiger.

- Integration in Rechtsrahmen – Data Poisoning könnte künftige Urheberrechtsgesetze beeinflussen.

- Plattformen für Kunst & Technik – Workshops und Bildungsangebote fördern gegenseitiges Verständnis.

Praktische Schritte für Künstler*innen und Cybersecurity-Profis

- Mit Bild-Perturbationen experimentieren.

- Glaze und Nightshade (nach Release) einsetzen.

- Trainingsdaten regelmäßig scannen.

- In der Community aktiv sein.

- Abwehrmechanismen gegen Data Poisoning entwickeln.

Fazit

Nightshade verschiebt den Blick auf Data Poisoning von der Offensiv- in die Defensivperspektive. Künstler*innen können ihre Bilder subtil vergiften, um unautorisierten Einsatz in KI-Trainings zu verhindern. Dieser Beitrag erklärte die Prinzipien, zeigte Codebeispiele und diskutierte rechtliche wie ethische Fragen. In einer Zukunft, in der generative KI weiter wächst, sind robuste und ethische Schutzmechanismen unerlässlich.

Literaturverzeichnis

- MIT Technology Review: This new data poisoning tool lets artists fight back against generative AI

- Usenix Security Conference

- Pillow Dokumentation

- NumPy Dokumentation

- OpenCV Dokumentation

- SciPy Dokumentation

- Introduction to Adversarial Machine Learning

In diesem Artikel haben wir die Balance zwischen künstlerischer Freiheit, Cybersecurity und verantwortungsvoller KI-Entwicklung untersucht. Durch das Verständnis von Nightshade und ähnlichen Data-Poisoning-Techniken können Beteiligte ihre kreativen Rechte und die Integrität von KI-Systemen besser schützen.

Bringen Sie Ihre Cybersecurity-Karriere auf die nächste Stufe

Wenn Sie diesen Inhalt wertvoll fanden, stellen Sie sich vor, was Sie mit unserem umfassenden 47-wöchigen Elite-Trainingsprogramm erreichen könnten. Schließen Sie sich über 1.200 Studenten an, die ihre Karrieren mit den Techniken der Unit 8200 transformiert haben.