Untitled Post

# IA Generativa y Cuatro Tipos de Engaño: Una Exploración Técnica Integral con Aplicaciones en Ciberseguridad

*Publicado el 29 de agosto de 2025 por Judith Simon*

Desde el otoño de 2022, la IA generativa ha tomado al mundo por sorpresa. Con millones de usuarios habituales, miles de millones de peticiones y un impacto cada vez mayor, las herramientas de IA generativa no solo han empezado a redefinir la expresión creativa, sino que también han introducido complejas preocupaciones éticas y epistemológicas. En esta entrada técnica de formato largo, exploramos el fenómeno de la IA generativa, diseccionamos lo que llamamos el “engaño cuádruple” derivado de su uso y analizamos cómo estas tendencias se intersectan con la ciberseguridad. Presentamos información que va desde conceptos introductorios hasta aplicaciones técnicas avanzadas, ejemplos del mundo real e incluso muestras de código en Bash y Python para ayudar a los profesionales de seguridad a comprender y mitigar algunas de estas amenazas emergentes.

---

## Tabla de Contenidos

1. [Introducción](#introducción)

2. [Comprendiendo la IA Generativa](#comprendiendo-la-ia-generativa)

- [¿Qué es la IA Generativa?](#qué-es-la-ia-generativa)

- [Los Mecanismos Subyacentes](#los-mecanismos-subyacentes)

3. [Engaño Cuádruple: Cuatro Tipos Distintos](#engaño-cuádruple-cuatro-tipos-distintos)

- [1. Engaño sobre el Estatus Ontológico](#engaño-sobre-el-estatus-ontológico)

- [2. Engaño acerca de las Capacidades de la IA](#engaño-acerca-de-las-capacidades-de-la-ia)

- [3. Engaño mediante Contenido Creado con IA Generativa](#engaño-mediante-contenido-creado-con-ia-generativa)

- [4. Engaño en la Integración y Funcionalidad](#engaño-en-la-integración-y-funcionalidad)

4. [IA Generativa en Ciberseguridad](#ia-generativa-en-ciberseguridad)

- [Cómo se Utiliza la IA en la Ciberseguridad Moderna](#cómo-se-utiliza-la-ia-en-la-ciberseguridad-moderna)

- [IA Generativa como Espada de Doble Filo](#ia-generativa-como-espada-de-doble-filo)

5. [Aplicaciones Prácticas en Ciberseguridad: Escaneo y Análisis](#aplicaciones-prácticas-en-ciberseguridad-escaneo-y-análisis)

- [Nivel Principiante: Escaneo de Red con Bash](#nivel-principiante-escaneo-de-red-con-bash)

- [Nivel Avanzado: Parseo de Salidas de Escaneo con Python](#nivel-avanzado-parseo-de-salidas-de-escaneo-con-python)

6. [Ejemplos Reales de Engaño y Ataques Cibernéticos Impulsados por IA](#ejemplos-reales-de-engaño-y-ataques-cibernéticos-impulsados-por-ia)

7. [Implicaciones Éticas y Estrategias de Mitigación](#implicaciones-éticas-y-estrategias-de-mitigación)

8. [Conclusión y Direcciones Futuras](#conclusión-y-direcciones-futuras)

9. [Referencias](#referencias)

---

## Introducción

La IA generativa hace referencia a una clase de algoritmos avanzados que producen contenido novedoso—texto, imágenes, audio o incluso vídeo—aprendiendo patrones a partir de conjuntos de datos masivos. Desde la generación de deepfakes realistas hasta la redacción de pasajes textuales de apariencia humana, estas tecnologías son capaces de crear salidas que imitan la creatividad humana con asombrosa precisión. Sin embargo, tales capacidades impresionantes conllevan riesgos igualmente impresionantes. En particular, la IA generativa introduce múltiples formas de engaño que pueden minar la confianza, tanto a nivel personal como sistémico.

En este artículo, exploramos cuatro tipos distintos de engaño que surgen con el uso generalizado de la IA generativa, examinando no solo sus implicaciones éticas y epistémicas, sino también su impacto potencial en la ciberseguridad. Este análisis interdisciplinario combina perspectivas filosóficas con detalles técnicos, ofreciendo a los profesionales de seguridad y tecnólogos una guía para comprender y mitigar novedosas amenazas impulsadas por IA.

---

## Comprendiendo la IA Generativa

### ¿Qué es la IA Generativa?

La IA generativa es un subconjunto de la inteligencia artificial que se centra en la creación de nuevo contenido aprendiendo a partir de grandes conjuntos de datos. A diferencia de los sistemas de IA tradicionales que clasifican o predicen basándose en patrones fijos, la IA generativa emplea técnicas como:

- **Aprendizaje Profundo** y *arquitecturas transformer* (por ejemplo, modelos GPT)

- **Variational Autoencoders (VAEs)**

- **Generative Adversarial Networks (GANs)**

Estos modelos funcionan descubriendo patrones estadísticos en enormes conjuntos de datos (a menudo extraídos de la web) y utilizando distribuciones de probabilidad para generar contenido nuevo que parezca coherente y relevante.

### Los Mecanismos Subyacentes

En esencia, la IA generativa se basa en un razonamiento probabilístico. Analizando un gran número de documentos o imágenes, la IA calcula la probabilidad de que un token o píxel siga a otro. Cuando se le solicita, “muestra” (sample) a partir de estas probabilidades aprendidas para construir salidas plausibles. Sin embargo, este mismo mecanismo implica que los resultados se sitúen en una zona de “suerte epistémica”: pueden ser correctos por casualidad pero carecer de fundamento en la verdad objetiva. Esto hace de la IA generativa una herramienta intrigante y, potencialmente, engañosa.

---

## Engaño Cuádruple: Cuatro Tipos Distintos

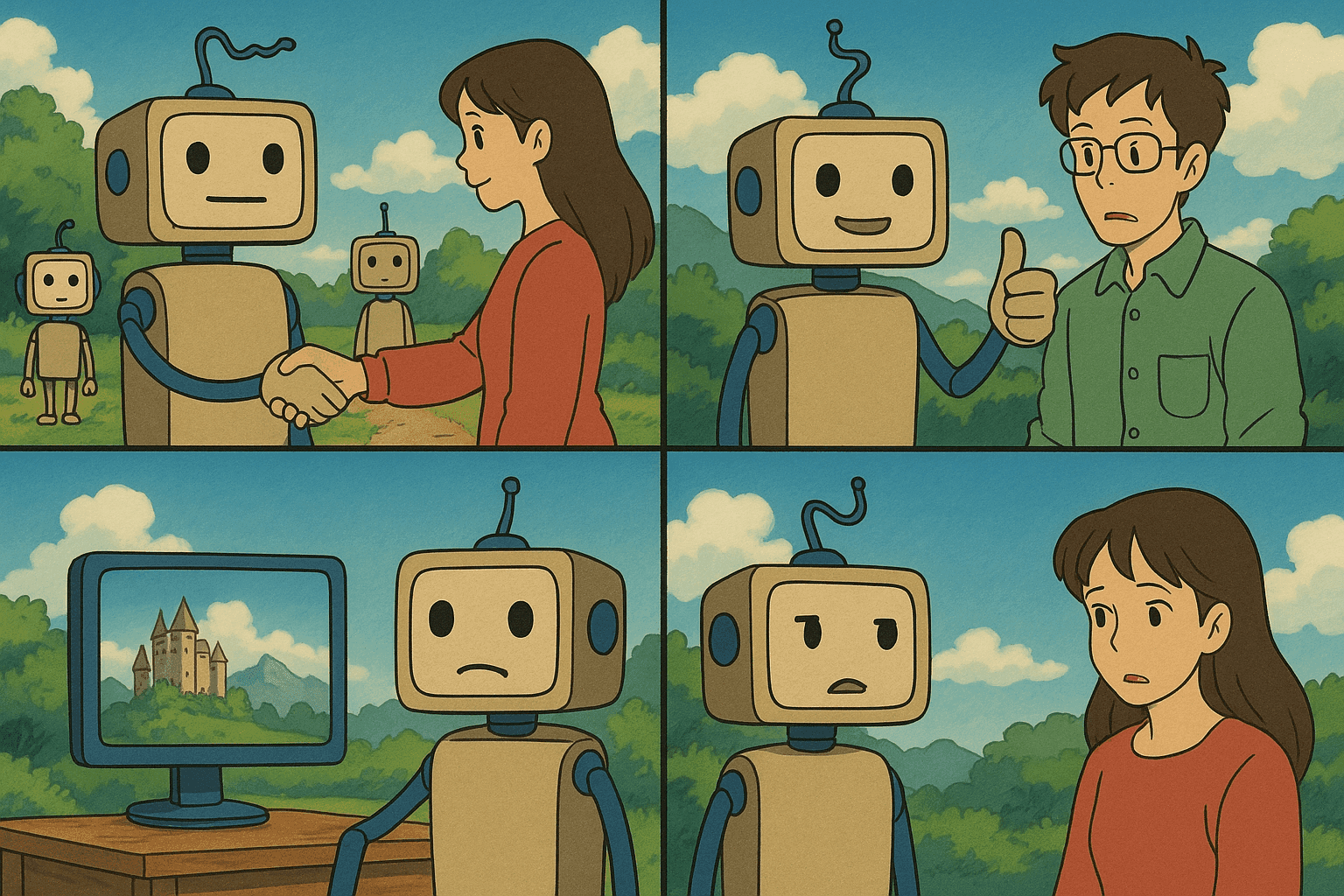

La creciente ubicuidad de la IA generativa da lugar a múltiples capas de potencial engaño. En esta sección, delineamos lo que llamamos el “engaño cuádruple”, un marco importante que incluye:

1. Engaño sobre el estatus ontológico de nuestro interlocutor

2. Engaño acerca de las capacidades de la IA

3. Engaño mediante el contenido creado con IA generativa

4. Engaño resultante de la integración de IA generativa en otros programas

Veamos cada tipo en detalle.

### Engaño sobre el Estatus Ontológico

Quizá la preocupación más inmediata sea que los usuarios pueden ser engañados respecto a con quién—o con qué—están interactuando. Por ejemplo, un usuario podría pensar que está chateando con un representante humano de atención al cliente, cuando en realidad interactúa con un chatbot sofisticado. Este “engaño ontológico” tiene precedentes históricos. El famoso “juego de imitación” de Alan Turing fue diseñado para evaluar si una máquina podía engañar a los humanos haciéndoles creer que era humana. Hoy, a medida que la IA generativa se vuelve ubicua, el riesgo se intensifica—no solo en el soporte al cliente sino en contextos como la psicoterapia, donde confundir a un humano con una máquina puede tener consecuencias significativamente mayores.

### Engaño acerca de las Capacidades de la IA

Desde que herramientas como ChatGPT se popularizaron, han aumentado las afirmaciones de que estos sistemas son más que simples generadores probabilísticos de texto. Algunos sostienen que los sistemas de IA exhiben empatía, comprensión o incluso conciencia. La tendencia a antropomorfizar las tecnologías de IA se remonta al programa ELIZA de Joseph Weizenbaum. A pesar de saber que se trata de algoritmos sofisticados, algunos usuarios continúan atribuyéndoles rasgos humanos. Tales conceptos erróneos pueden llevar a la sobreconfianza o a una confianza mal depositada, causando daños psicológicos o institucionales graves.

### Engaño mediante Contenido Creado con IA Generativa

El tercer tipo de engaño implica la creación y difusión de contenido engañoso. La IA generativa puede emplearse para fabricar imágenes realistas (deepfakes), producir artículos científicos falsos o generar propaganda convincente. Aunque las tácticas de desinformación tienen una larga historia, la velocidad y facilidad con las que la IA moderna puede crear desinformación persuasiva supone una amenaza considerable, especialmente cuando se combina con las redes sociales y otros canales de distribución rápida.

### Engaño en la Integración y Funcionalidad

El cuarto tipo de engaño es más sutil: surge cuando la IA generativa se integra en otros sistemas, como motores de búsqueda o plataformas de atención al cliente, y se exageran sus capacidades. Los usuarios podrían asumir que una herramienta como ChatGPT está proporcionando resultados verificados y comprobados, a pesar de que su mecanismo subyacente es un simple emparejamiento estadístico sin garantía de precisión. Esto puede tener efectos adversos en la fiabilidad de la información y, a su vez, en la postura general de ciberseguridad—particularmente cuando estos sistemas se utilizan para tareas críticas de toma de decisiones.

---

## IA Generativa en Ciberseguridad

A medida que la IA generativa se cruza con diversos dominios, su impacto en la ciberseguridad se ha convertido en un tema de intenso escrutinio. Por un lado, la IA ofrece herramientas transformadoras para detectar vulnerabilidades y realizar evaluaciones de amenazas en tiempo real; por otro, la misma tecnología puede ser armada para engañar o comprometer sistemas.

### Cómo se Utiliza la IA en la Ciberseguridad Moderna

Tradicionalmente, la ciberseguridad se ha basado en métodos de detección por firmas y detección de anomalías. Hoy, la IA refuerza estas técnicas mediante:

- **Reconocimiento de Patrones:** Identificación de tráfico de red inusual, dispositivos inactivos o desviaciones del comportamiento normal de los usuarios.

- **Simulaciones de Amenazas:** Generación proactiva de vectores de ataque plausibles para probar la resiliencia de un sistema.

- **Escaneo Automatizado de Vulnerabilidades:** Uso de aprendizaje automático para detectar vulnerabilidades más rápido que los métodos manuales.

Por ejemplo, muchas organizaciones integran sistemas impulsados por IA para monitorear continuamente sus redes, marcar automáticamente actividades sospechosas e incluso sugerir medidas correctivas. Las mismas capacidades generativas pueden emplearse para simular ataques de ingeniería social, como correos electrónicos o mensajes engañosos que pongan a prueba la vulnerabilidad de los empleados.

### IA Generativa como Espada de Doble Filo

Así como la IA generativa se utiliza para la defensa en ciberseguridad, los adversarios pueden emplearla para crear estafas de phishing más convincentes, comunicaciones maliciosas de comando y control, e incluso mensajes de audio o vídeo manipulados para secuestrar la confianza. La facilidad con la que estas amenazas engañosas pueden generarse y difundirse incrementa la necesidad de sistemas de verificación mejorados y normas éticas transversales.

Por ejemplo, un atacante podría utilizar un modelo de IA generativa para crear un mensaje falso, pero convincente, supuestamente enviado por el CEO de la empresa, instruyendo a un empleado a transferir fondos o revelar credenciales confidenciales. Este uso de la IA para imitar voces, estilos de escritura o identidades visuales hace que los métodos tradicionales de autenticación sean menos fiables.

---

## Aplicaciones Prácticas en Ciberseguridad: Escaneo y Análisis

En esta sección, presentamos algunas técnicas prácticas de ciberseguridad mejoradas con la ayuda de la IA generativa. Cubrimos cómo escanear redes usando comandos Bash y luego analizar la salida con Python para identificar vulnerabilidades.

### Nivel Principiante: Escaneo de Red con Bash

El escaneo de red es una habilidad fundamental en ciberseguridad, utilizada para detectar puertos abiertos, identificar servicios en ejecución y mapear la topología de la red. En entornos Linux, herramientas como **nmap** son ampliamente usadas para este propósito.

A continuación, un script Bash que utiliza nmap para el escaneo de red:

```bash

#!/bin/bash

# network_scan.sh - Un script simple de escaneo de red usando nmap

# Comprobar si se proporcionó un argumento (IP o hostname)

if [ -z "$1" ]; then

echo "Uso: $0 <IP_o_hostname_destino>"

exit 1

fi

TARGET=$1

OUTPUT_FILE="scan_results.txt"

echo "Escaneando objetivo: $TARGET"

nmap -v -A $TARGET -oN $OUTPUT_FILE

echo "Escaneo completado. Los resultados se guardaron en $OUTPUT_FILE."

Explicación:

- El script comprueba que se haya introducido un destino válido.

- Ejecuta nmap con las opciones verbose (-v) y aggressive (-A) para habilitar detección de SO, detección de versiones y scripts de nmap.

- La salida se guarda en

scan_results.txtpara su análisis posterior.

Este script Bash puede mejorarse programando escaneos regulares mediante cron o integrándolo con herramientas SIEM para alertas en tiempo real.

Nivel Avanzado: Parseo de Salidas de Escaneo con Python

Después del escaneo, los profesionales de seguridad a menudo necesitan automatizar el procesamiento de los resultados para identificar rápidamente vulnerabilidades. Python es excelente para este propósito—especialmente cuando se combina con bibliotecas como re para expresiones regulares o xml.etree.ElementTree si la salida del escaneo está en formato XML.

A continuación, un script Python que analiza una salida simple de nmap en texto. Supondremos que el formato de salida incluye líneas como “PORT STATE SERVICE”.

#!/usr/bin/env python3

"""

parse_scan.py - Script en Python para analizar resultados de nmap e identificar puertos abiertos.

"""

import re

def parse_scan_results(filename):

open_ports = []

try:

with open(filename, 'r') as file:

for line in file:

# Suponemos que nmap genera líneas como "80/tcp open http"

match = re.search(r"(\d+)/tcp\s+open\s+(\S+)", line)

if match:

port = match.group(1)

service = match.group(2)

open_ports.append((port, service))

except FileNotFoundError:

print(f"Error: Archivo {filename} no encontrado.")

return open_ports

if __name__ == '__main__':

results_file = "scan_results.txt"

ports = parse_scan_results(results_file)

if ports:

print("Puertos abiertos detectados:")

for port, service in ports:

print(f"- Puerto {port} ejecutando {service}")

else:

print("No se encontraron puertos abiertos o no hay datos de escaneo válidos.")

Explicación:

- El script lee del archivo de resultados generado previamente.

- Utiliza una expresión regular para capturar líneas que indiquen puertos abiertos.

- Muestra una lista de puertos abiertos y los servicios detectados, que pueden utilizarse para evaluaciones automatizadas de vulnerabilidades.

Este ejemplo demuestra cómo los profesionales de ciberseguridad pueden integrar métodos de escaneo tradicionales con automatización moderna para mantener una defensa robusta—una práctica crucial al enfrentarse a amenazas cibernéticas potenciadas por IA.

Ejemplos Reales de Engaño y Ataques Cibernéticos Impulsados por IA

Deepfakes en Propaganda Política

Los acontecimientos mundiales recientes han presenciado el auge de los deepfakes—vídeos o audios manipulados por IA para suplantar a líderes políticos. En un caso, un vídeo deepfake de un político conocido emitiendo declaraciones controvertidas se volvió viral, generando disturbios públicos antes de ser desmentido. La rápida producción y difusión de dicho material planteó preocupaciones sobre la interferencia electoral y la manipulación del discurso público.

Ataques de Phishing Potenciados por IA

Los ciberdelincuentes emplean ahora IA generativa para crear correos de phishing personalizados. Al recopilar datos de redes sociales y sitios corporativos, la IA puede producir mensajes que imitan el tono y estilo de colegas de confianza o directivos. En un incidente reportado, un empleado recibió un correo que copió a la perfección el estilo de escritura de su CEO, lo que acabó comprometiendo datos financieros sensibles.

Descubrimiento Automatizado de Vulnerabilidades

En el lado defensivo, las empresas utilizan la IA para automatizar el descubrimiento de vulnerabilidades de software. Generando miles de iteraciones de código, los sistemas impulsados por IA pueden simular vectores de ataque mucho más rápido que las pruebas manuales. Aunque esto ayuda a parchear vulnerabilidades antes de que sean explotadas, también alerta a los adversarios de la posibilidad de aplicar técnicas similares. En estos casos, la IA generativa actúa como espada de doble filo.

Ingeniería Social mediante Chatbots de IA

Se han documentado casos alarmantes de personas que buscaban apoyo emocional durante crisis a través de plataformas digitales, solo para descubrir que interactuaban con chatbots de IA. En algunos escenarios, los usuarios interpretaron el lenguaje empático generado por la IA como empatía humana genuina, lo que condujo a una confianza mal depositada. Si actores maliciosos explotan estas situaciones, podrían manipular a usuarios vulnerables para que revelen información personal o realicen acciones arriesgadas.

Implicaciones Éticas y Estrategias de Mitigación

Dilemas Éticos

Las cuestiones éticas planteadas por la IA generativa son vastas. El modelo de engaño cuádruple que hemos discutido pone estos retos en primer plano:

- Confiabilidad: A medida que los usuarios son engañados sobre el estatus ontológico y las capacidades de la IA, la confianza mal depositada puede tener consecuencias graves.

- Atribución de Responsabilidad: Eliminar el requisito de engaño intencional facilita responsabilizar a desarrolladores y corporaciones por daños no intencionados, pero también difumina las líneas de responsabilidad en casos de consecuencias imprevistas.

- Impacto Social: El uso indebido de la IA generativa para fabricar contenido engañoso puede erosionar la confianza pública en los medios y las instituciones.

Estrategias de Mitigación

Ante estas preocupaciones éticas y de ciberseguridad, se han propuesto varias estrategias:

- Transparencia y Explicabilidad: Los desarrolladores deben adoptar prácticas que aseguren que los sistemas de IA sean transparentes sobre sus capacidades y limitaciones. Disclaimers o marcas de agua en el contenido generado pueden ayudar a mitigar el engaño de origen.

- Protocolos de Autenticación: Implementar autenticación multifactor robusta y verificar identidades digitales reduce riesgos de phishing y suplantación.

- Regulación y Supervisión: Los responsables políticos deben colaborar con tecnólogos para definir directrices éticas y marcos regulatorios sólidos.

- Educación del Usuario: Formar continuamente a consumidores y organizaciones acerca de las limitaciones y usos apropiados de la IA generativa es crucial.

- Ciberseguridad Potenciada por IA: Desarrollar algoritmos que detecten rápidamente anomalías en contenido, verifiquen autenticidad digital y correlacionen actividades sospechosas es una línea de defensa esencial.

Conclusión y Direcciones Futuras

La IA generativa se erige como uno de los avances tecnológicos más transformadores de nuestro tiempo. Su capacidad para producir texto, imágenes e incluso conversaciones interactivas ha dado lugar a múltiples formas de engaño, con amplias implicaciones éticas, epistémicas y de ciberseguridad.

Esta publicación ha proporcionado un análisis profundo del modelo de engaño cuádruple—centrado en el estatus ontológico, las capacidades de la IA, la generación de contenido y la integración funcional—todos ellos aspectos cruciales para comprender el impacto de la IA generativa. Conectamos estos temas con problemas actuales de ciberseguridad mediante técnicas prácticas de escaneo, ofreciendo scripts de Bash para principiantes y de Python para usuarios avanzados.

A medida que el campo de la IA generativa evoluciona, también deben hacerlo nuestros enfoques éticos y técnicos. Desarrolladores, expertos en ciberseguridad, legisladores y usuarios cotidianos deben colaborar para crear sistemas robustos que aprovechen los beneficios de la IA minimizando sus riesgos. La investigación futura debe centrarse en desarrollar sistemas de IA autoauditable, resilientes a manipulaciones y capaces de proporcionar salidas verificables. Mediante prácticas transparentes y éticas, y la mejora continua de las medidas de ciberseguridad, podremos navegar de forma más segura por las aguas turbulentas del engaño impulsado por IA.

Referencias

- Informe de Riesgos Globales 2024 del Foro Económico Mundial

- El Juego de Imitación y la Prueba de Turing de Alan Turing

- Documentación Oficial de Nmap

- Documentación Oficial de Python

- Panorama de Generative Adversarial Networks (GANs)

- Comprendiendo los Deepfakes y su Impacto

Esta publicación integral tiende un puente entre la discusión filosófica sobre el engaño y los retos contemporáneos en ciberseguridad. A medida que la IA generativa continúa influyendo en cada faceta de la tecnología y la sociedad, el discurso informado y las medidas técnicas proactivas siguen siendo nuestra mejor defensa contra sus posibles perjuicios. Manteniéndonos a la vanguardia, adoptando prácticas éticas robustas y actualizando continuamente nuestras técnicas de ciberseguridad, podremos aprovechar el poder de la IA de forma responsable y segura.

No dudes en compartir tus opiniones, suscribirte para recibir actualizaciones o profundizar en cualquier sección siguiendo los enlaces proporcionados. Juntos podemos construir un futuro digital más seguro y confiable.

Lleva tu Carrera de Ciberseguridad al Siguiente Nivel

Si encontraste este contenido valioso, imagina lo que podrías lograr con nuestro programa de capacitación élite integral de 47 semanas. Únete a más de 1.200 estudiantes que han transformado sus carreras con las técnicas de la Unidad 8200.