Untitled Post

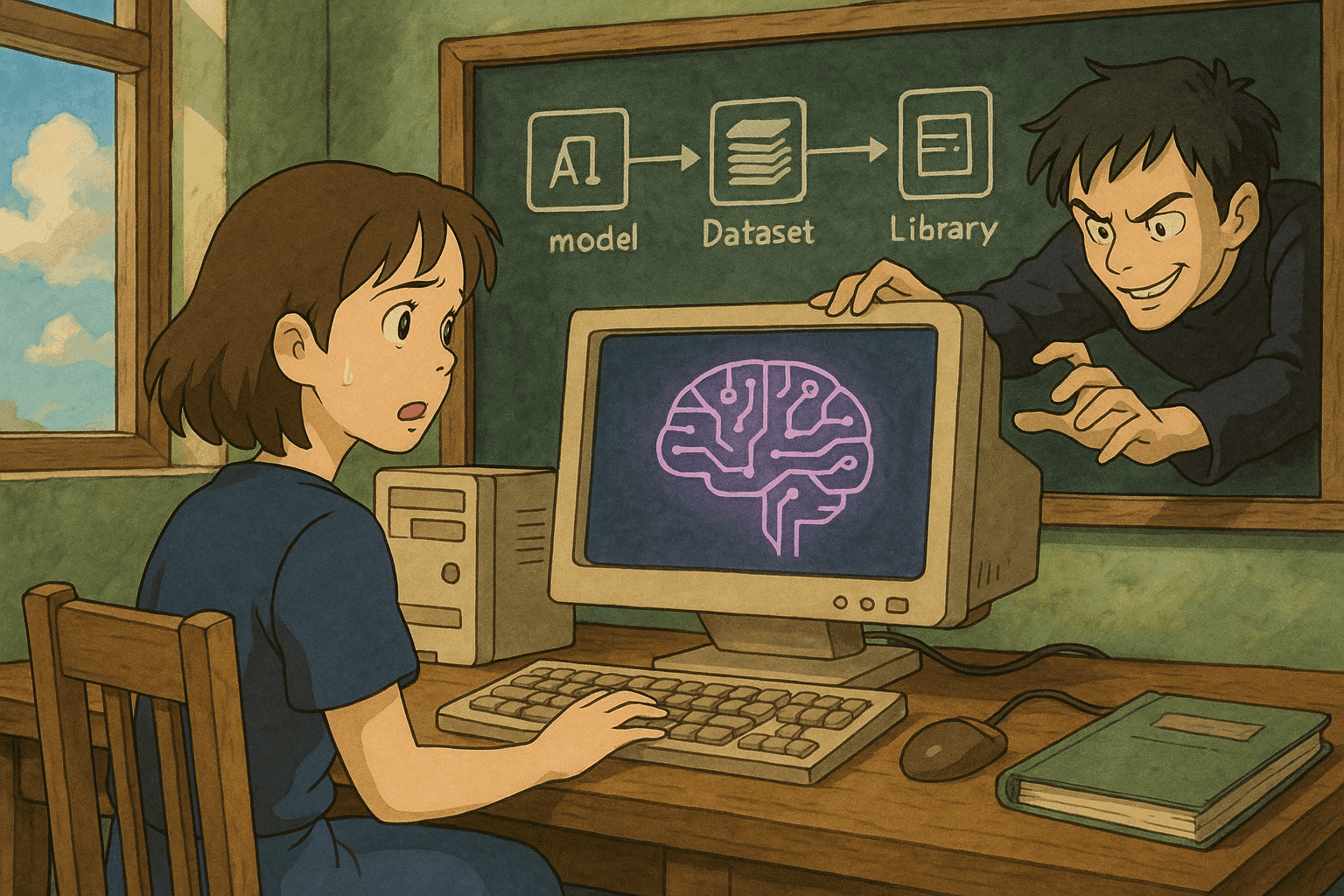

# Abusando las cadenas de suministro de IA: Cómo los modelos, datos y bibliotecas de terceros envenenados comprometen los sistemas de IA

*Autor: [Tu Nombre]*

*Fecha: 18 de agosto de 2025*

La Inteligencia Artificial (IA) está transformando rápidamente los negocios en todos los sectores. Sin embargo, como ocurre con toda innovación, los sistemas de IA no están exentos de vulnerabilidades. En los últimos años, los ataques a la cadena de suministro dirigidos a artefactos de IA—incluidos modelos envenenados, datos manipulados y bibliotecas de terceros comprometidas—han surgido como una amenaza significativa. Esta entrada de blog explora las distintas formas en que los adversarios pueden comprometer los sistemas de IA a través de la cadena de suministro, explica los vectores de ataque más comunes, proporciona ejemplos del mundo real y muestra fragmentos de código que ayudan a escanear y analizar salidas de vulnerabilidades usando Bash y Python.

---

## Tabla de Contenidos

1. [Introducción](#introducción)

2. [Comprender la cadena de suministro de IA](#comprender-la-cadena-de-suministro-de-ia)

3. [Vectores de ataque comunes en las cadenas de suministro de IA](#vectores-de-ataque-comunes)

- [Envenenamiento de modelos](#envenenamiento-de-modelos)

- [Compromiso de las canalizaciones de datos](#compromiso-de-las-canalizaciones-de-datos)

- [Explotación de bibliotecas de terceros](#explotación-de-bibliotecas-de-terceros)

4. [Ejemplos del mundo real](#ejemplos-del-mundo-real)

5. [Ejemplos de código para escanear y analizar vulnerabilidades](#ejemplos-de-código)

- [Ejemplo de Bash: escanear paquetes vulnerables](#ejemplo-de-bash)

- [Ejemplo de Python: analizar la salida del escaneo de vulnerabilidades](#ejemplo-de-python)

6. [Buenas prácticas para asegurar las cadenas de suministro de IA](#buenas-prácticas)

7. [Conclusión](#conclusión)

8. [Referencias](#referencias)

---

## Introducción

Los sistemas de IA modernos dependen de cadenas de suministro complejas que incluyen modelos preentrenados, conjuntos de datos y una infinidad de bibliotecas de terceros. Si bien estos componentes aceleran el desarrollo y la implementación, también introducen posibles vectores de ataque para actores maliciosos. Un atacante que logre modificar cualquier elemento de la cadena de suministro de IA puede inyectar datos envenenados, alterar el comportamiento del modelo o introducir errores sutiles que permanezcan sin detectar hasta explotarse en producción.

En esta publicación, nos sumergimos en “Abusando las cadenas de suministro: Cómo los modelos, datos y bibliotecas de terceros envenenados comprometen los sistemas de IA”. Explicamos cómo los atacantes obtienen acceso inicial, evitan la detección y utilizan credenciales o recursos mal gestionados para explotar aún más las infraestructuras de IA. Esta guía integral está diseñada para científicos de datos, ingenieros de seguridad y profesionales de DevOps que necesitan proteger las canalizaciones de IA.

---

## Comprender la cadena de suministro de IA

Una cadena de suministro de IA comprende todos los componentes internos y externos que contribuyen al desarrollo, entrenamiento, despliegue y operación de un modelo de IA. Estos componentes incluyen:

- **Modelos preentrenados y checkpoints:** A menudo obtenidos de repositorios públicos o proveedores de terceros.

- **Conjuntos de datos:** Utilizados para entrenar o afinar modelos; pueden ser recopilados, curados o comprados.

- **Bibliotecas de terceros:** Marcos de trabajo, herramientas y utilidades de código abierto que ayudan a construir canalizaciones de IA.

- **Herramientas de despliegue:** Recursos en la nube, APIs y canalizaciones CI/CD que llevan la IA a producción.

Cada componente es un punto potencial de compromiso y, si uno se ve afectado, el atacante puede propagar los efectos aguas abajo hasta impactar el sistema de IA en su conjunto.

---

## Vectores de ataque comunes

En esta sección, clasificamos los principales vectores de ataque asociados al abuso de la cadena de suministro de IA y proporcionamos una explicación detallada de cada uno.

### Envenenamiento de modelos

**Definición:** El envenenamiento de modelos ocurre cuando un adversario inyecta deliberadamente patrones maliciosos en los datos de entrenamiento o modifica los pesos del modelo para que éste se comporte de forma errática. En casos extremos, el modelo envenenado puede clasificar incorrectamente entradas críticas, filtrar datos sensibles o causar daños financieros.

**Escenario de ataque:**

- Un modelo preentrenado ampliamente utilizado se comparte en un repositorio de código abierto.

- Un atacante envía una _pull request_ con modificaciones sutiles en el script de entrenamiento o los pesos.

- Una vez que se implementa la versión envenenada, el modelo clasifica mal entradas críticas (p. ej., un sistema de detección de fraude deja pasar actividades fraudulentas).

**Impacto:**

- Degradación del rendimiento del modelo.

- Predicciones inexactas.

- Pérdida de confianza en modelos de terceros.

### Compromiso de las canalizaciones de datos

**Definición:** El envenenamiento de datos implica alterar deliberadamente los datos de entrenamiento antes de que se usen, de modo que el sistema de IA resultante aprenda correlaciones espurias o sesgos. Esta técnica es especialmente peligrosa porque las anomalías en los datos pueden ser difíciles de detectar estadísticamente.

**Escenario de ataque:**

- Un adversario consigue acceso de escritura limitado al almacenamiento de datos o a la canalización de ingestión.

- Introduce muestras de datos maliciosas que el modelo interpreta como señales legítimas.

- Con el tiempo, la salida del modelo se manipula para provocar decisiones críticas de seguridad, como clasificar incorrectamente una amenaza cibernética o dar un diagnóstico médico erróneo.

**Impacto:**

- Disminución de la precisión de las predicciones.

- Aumento del sesgo del modelo.

- Posible explotación adversarial en tiempo de inferencia.

### Explotación de bibliotecas de terceros

**Definición:** La explotación de bibliotecas de terceros ocurre cuando un adversario modifica sutilmente librerías de código abierto o introduce código malicioso en dependencias. Dado que los sistemas de IA dependen a menudo de cientos de estas librerías, una vulnerabilidad en una sola puede comprometer toda la aplicación.

**Escenario de ataque:**

- Un actor malicioso inyecta una vulnerabilidad en un paquete Python popular utilizado por varios proyectos de IA (p. ej., mediante _typosquatting_ o _dependency confusion_).

- Cuando los proyectos actualizan o instalan este paquete, se ejecuta el código malicioso.

- Esto puede crear puertas traseras, exfiltrar datos o escalar privilegios en el entorno de producción.

**Impacto:**

- Ataques a la cadena de suministro a gran escala.

- Puertas traseras persistentes y ocultas en entornos de producción.

- Difícil detección si la modificación es sutil.

---

## Ejemplos del mundo real

Los escenarios teóricos de ataque a la cadena de suministro de IA no son hipotéticos. Varias incidencias de alto perfil demuestran cómo las vulnerabilidades de la cadena de suministro pueden comprometer incluso los sistemas de IA más avanzados.

### Ejemplo 1: Compromiso de un repositorio de modelos de código abierto

En un incidente bien documentado, los atacantes explotaron una vulnerabilidad en un repositorio de modelos popular. Presentaron una _pull request_ que parecía optimizar el rendimiento del modelo, pero contenía lógica oculta para producir malas clasificaciones bajo ciertas condiciones. Esta versión envenenada pasó desapercibida hasta que los usuarios finales reportaron fallos inexplicables en aplicaciones críticas, lo que provocó una retirada mayor y pérdida de confianza de los clientes.

### Ejemplo 2: Envenenamiento de datos en servicios financieros

Una gran institución financiera sufrió envenenamiento de datos cuando un adversario, con acceso a la canalización de datos interna, comenzó a inyectar pequeños lotes de registros de transacciones alterados. Con el tiempo, el modelo de aprendizaje automático utilizado para la detección de fraudes dejó de identificar actividades fraudulentas reales. El incidente provocó pérdidas financieras sustanciales y puso de manifiesto la necesidad crítica de asegurar las canalizaciones de datos.

### Ejemplo 3: Explotación de vulnerabilidad en una biblioteca de terceros

Varias organizaciones que utilizaban un paquete Python ampliamente adoptado para procesamiento de datos se vieron afectadas por un incidente de seguridad grave. Una actualización maliciosa del paquete contenía una puerta trasera que permitía la ejecución remota de código. La actualización, distribuida a través del índice público de paquetes, afectó a docenas de aplicaciones impulsadas por IA en todo el mundo hasta que fue identificada mediante monitoreo multiplataforma y una rápida respuesta al incidente.

---

## Ejemplos de código

Para ayudarte a adoptar medidas proactivas contra el abuso de la cadena de suministro, aquí tienes algunos ejemplos prácticos usando Bash y Python.

### Ejemplo de Bash: escanear paquetes vulnerables

El siguiente script Bash utiliza la herramienta de código abierto “safety” (un verificador de vulnerabilidades para paquetes Python) para buscar problemas de seguridad conocidos en las dependencias de tu proyecto. Asegúrate de instalar _safety_ primero con `pip install safety`.

```bash

#!/bin/bash

# scan_packages.sh: Escanea vulnerabilidades en las dependencias de tu proyecto Python

# Asegura que exista el archivo de requisitos

REQUIREMENTS_FILE="requirements.txt"

if [ ! -f "$REQUIREMENTS_FILE" ]; then

echo "Error: ¡$REQUIREMENTS_FILE no encontrado!"

exit 1

fi

echo "Escaneando dependencias en busca de vulnerabilidades..."

# Usa safety para comprobar el archivo de requisitos

safety check -r "$REQUIREMENTS_FILE" --full-report

# Comprueba el estado de salida del comando

if [ $? -ne 0 ]; then

echo "Vulnerabilidades detectadas. Por favor revisa el reporte anterior."

exit 1

else

echo "¡No se detectaron vulnerabilidades conocidas en tus dependencias!"

fi

Instrucciones de uso:

- Guarda el script como

scan_packages.sh. - Asegúrate de que sea ejecutable con:

chmod +x scan_packages.sh - Ejecuta el script:

./scan_packages.sh

Este script es una forma rápida de integrar el escaneo de vulnerabilidades en tus canalizaciones CI/CD y proteger tu proceso de despliegue frente a la explotación de bibliotecas de terceros.

Ejemplo de Python: analizar la salida del escaneo de vulnerabilidades

Imagina que dispones de la salida de un escáner de vulnerabilidades y deseas analizar los resultados programáticamente para agregarlos o generar alertas. El siguiente script Python muestra cómo hacerlo.

#!/usr/bin/env python3

"""

parse_vulnerabilities.py: Script para analizar salidas de escaneo de vulnerabilidades.

Se asume que la salida está en formato JSON generada por un escáner hipotético.

"""

import json

import sys

def parse_vulnerabilities(output_file):

try:

with open(output_file, 'r') as file:

vulnerabilities = json.load(file)

except Exception as e:

print(f"Error al leer {output_file}: {e}")

sys.exit(1)

if not vulnerabilities.get("vulnerabilities"):

print("¡No se encontraron vulnerabilidades en la salida del escaneo!")

return

# Recorre las vulnerabilidades y muestra un resumen

for vul in vulnerabilities["vulnerabilities"]:

package = vul.get("package", "Desconocido")

version = vul.get("version", "Desconocido")

advisory = vul.get("advisory", "Sin aviso proporcionado")

severity = vul.get("severity", "Desconocida").upper()

print(f"Paquete: {package}")

print(f"Versión: {version}")

print(f"Severidad: {severity}")

print(f"Aviso: {advisory}")

print("-" * 40)

if __name__ == "__main__":

if len(sys.argv) != 2:

print("Uso: python3 parse_vulnerabilities.py <output_file.json>")

sys.exit(1)

parse_vulnerabilities(sys.argv[1])

Instrucciones de uso:

- Guarda el código como

parse_vulnerabilities.py. - Asegúrate de tener un archivo JSON de salida de tu escáner de vulnerabilidades.

- Ejecuta el script:

python3 parse_vulnerabilities.py scan_output.json

Este script te permite analizar vulnerabilidades de forma programática y puede integrarse en paneles de control o sistemas de alertas para una gestión proactiva de amenazas.

Buenas prácticas para asegurar las cadenas de suministro de IA

Proteger los sistemas de IA del abuso de la cadena de suministro requiere un enfoque de seguridad en múltiples capas. A continuación, algunas recomendaciones:

1. Asegura tus canalizaciones de datos

- Autenticación y control de acceso: Restringe los permisos de escritura en las canalizaciones y almacenamientos de datos.

- Validación de datos: Implementa validación rigurosa y detección de anomalías para identificar datos envenenados.

- Auditoría y monitoreo: Supervisa continuamente las canalizaciones de datos ante modificaciones inusuales o patrones inesperados.

2. Valida los componentes de terceros

- Gestión de dependencias: Utiliza herramientas como Dependabot, Snyk o safety para escanear y actualizar dependencias automáticamente.

- Seguridad de la cadena de suministro: Asegúrate de que las bibliotecas provengan de repositorios confiables y considera la verificación de firmas criptográficas.

- Aislamiento y contenedorización: Ejecuta código de terceros en entornos aislados (p. ej., contenedores) para minimizar el impacto de una brecha.

3. Monitorea y audita los modelos de IA

- Verificación de integridad del modelo: Utiliza hashes y firmas digitales para verificar que los modelos en producción coincidan con versiones verificadas.

- Monitoreo de comportamiento: Despliega sistemas que vigilen continuamente el comportamiento del modelo en inferencia y alerten sobre desviaciones.

- Herramientas de explicabilidad: Implementa herramientas de interpretabilidad que ayuden a detectar si el proceso de decisión del modelo ha sido manipulado.

4. Prácticas de seguridad automatizadas en CI/CD

- Integración con herramientas de seguridad: Incorpora análisis estático, escaneo de dependencias y escaneo de contenedores en tus canalizaciones CI/CD.

- Actualizaciones y parches regulares: Mantén un programa agresivo de gestión de parches para todos los componentes de software.

- Planes de respuesta e recuperación: Desarrolla procedimientos claros de detección, respuesta y recuperación de incidentes específicos para plataformas de IA.

5. Capacita y forma a los equipos

- Formación en seguridad: Asegura que todos los miembros involucrados en el desarrollo y despliegue de IA entiendan los riesgos de la cadena de suministro.

- Revisiones y auditorías de código: Realiza revisiones de código y auditorías de seguridad regulares para componentes internos y de terceros.

- Colaboración interdisciplinaria: Fomenta la colaboración entre ciencia de datos, DevOps y ciberseguridad para construir sistemas resilientes.

Siguiendo estas buenas prácticas, las organizaciones pueden mitigar significativamente los riesgos asociados con los ataques a la cadena de suministro de IA.

Conclusión

A medida que los sistemas de IA se vuelven más críticos para las operaciones y la toma de decisiones empresariales, los actores maliciosos continúan innovando para atacar cada eslabón de la cadena de suministro. Ya sea envenenando modelos, manipulando datos de entrenamiento o comprometiendo bibliotecas de terceros, los riesgos son reales y evolucionan rápidamente. La aparición de estos ataques sofisticados tiene un impacto profundo en la confianza y la seguridad.

Asegurar la cadena de suministro de IA requiere un enfoque proactivo—combinando auditorías sólidas, monitoreo continuo y herramientas de seguridad automatizadas en un ecosistema bien integrado. Herramientas como Datadog, nombrada Líder en el Gartner® Magic Quadrant™ para Plataformas de Observabilidad, proporcionan la observabilidad y los insights necesarios para detectar anomalías y amenazas en tiempo real.

Esta guía detallada presentó información técnica sobre cómo operan los atacantes, ejemplos reales de vulnerabilidades en la cadena de suministro y ejemplos prácticos de código que puedes integrar en tus propios procesos de seguridad. Al mantenerte informado e implementar medidas de seguridad rigurosas, las organizaciones pueden reducir el riesgo de abuso en la cadena de suministro y generar confianza en sus sistemas de IA.

Referencias

- Datadog: Plataforma de Observabilidad y Seguridad

- Gartner Magic Quadrant for Observability Platforms

- Safety – Verificador de vulnerabilidades en dependencias Python

- OWASP Software Component Verification Standard (SCVS)

- Dependabot – Actualizaciones automáticas de dependencias

- Snyk – Seguridad para dependencias de código abierto

Con la creciente sofisticación de los ataques a la cadena de suministro dirigidos a los sistemas de IA, mantenerse vigilante y mejorar continuamente tu postura de seguridad es más crucial que nunca. Al integrar las estrategias y prácticas descritas en esta publicación, podrás ayudar a proteger tus despliegues de IA contra envenenamiento, manipulación de datos y compromisos de bibliotecas de terceros.

Recuerda, la seguridad en IA no es un proyecto de una sola vez—es un proceso continuo que debe evolucionar junto con tus sistemas y el panorama de amenazas.

¡Feliz codificación y mantente seguro!

Lleva tu Carrera de Ciberseguridad al Siguiente Nivel

Si encontraste este contenido valioso, imagina lo que podrías lograr con nuestro programa de capacitación élite integral de 47 semanas. Únete a más de 1.200 estudiantes que han transformado sus carreras con las técnicas de la Unidad 8200.