Untitled Post

Nightshade: Una herramienta revolucionaria de envenenamiento de datos para contraatacar a la IA generativa

Publicado en MIT Technology Review e inspirado en una investigación pionera, Nightshade es una nueva herramienta de envenenamiento de datos diseñada para ayudar a artistas, investigadores y profesionales de ciberseguridad a comprender y contrarrestar el uso indebido de obras creativas en los modelos de IA generativa.

En la era digital actual, los modelos de IA generativa como DALL-E, Midjourney y Stable Diffusion encabezan la innovación. Sin embargo, estos modelos se entrenan con grandes volúmenes de datos extraídos de Internet, datos que a menudo incluyen obras de arte producidas por talentosos artistas sin su consentimiento. Este uso no autorizado ha suscitado un intenso debate sobre los derechos de propiedad intelectual, la titularidad de los datos y las implicaciones éticas de las prácticas de entrenamiento de IA. En respuesta, los investigadores han desarrollado herramientas como Nightshade que permiten a los artistas “envenenar” sus imágenes antes de que formen parte de esos enormes conjuntos de entrenamiento. Esta publicación técnica de formato largo explora Nightshade en detalle, profundizando en la tecnología que la sustenta, sus implicaciones en ciberseguridad y ejemplos prácticos con código para ayudar tanto a principiantes como a usuarios avanzados a comprender este enfoque innovador.

Índice

- Introducción

- IA generativa, copyright y la necesidad de protección de datos

- Comprender el envenenamiento de datos

- Cómo funciona Nightshade

- Implementación técnica de técnicas tipo Nightshade

- Una perspectiva de ciberseguridad sobre el envenenamiento de datos en IA

- Ejemplos reales y casos de uso

- Implicaciones legales y éticas

- Futuras direcciones en seguridad de datos e IA

- Conclusión

- Referencias

Introducción

La IA generativa ha revolucionado el mundo, ofreciendo la capacidad de crear imágenes, arte e incluso contenido textual realista a partir de indicaciones. Sin embargo, estos avances conllevan desafíos importantes. La principal preocupación de la comunidad artística es que las empresas de IA rastrean millones—e incluso miles de millones—de imágenes en línea para entrenar sus modelos. Los artistas descubren que su trabajo se utiliza sin permiso, abriendo el debate sobre derechos de autor y propiedad intelectual.

Nightshade presenta un enfoque proactivo que permite a los artistas y creadores “envenenar” sus imágenes de forma sutil. Cuando estas imágenes se incorporan a conjuntos de entrenamiento, las ligeras perturbaciones pueden hacer que los modelos de IA generativa interpreten mal los datos, generando salidas inesperadas y caóticas. En esta publicación profundizamos en los aspectos técnicos y de ciberseguridad de esta innovación, aportando información sobre su funcionamiento, sus beneficios potenciales y la tecnología subyacente.

IA generativa, copyright y la necesidad de protección de datos

El auge de la IA generativa

Los sistemas de IA generativa han revolucionado las industrias creativas. Al aprender de enormes conjuntos de datos, estos sistemas pueden generar imágenes, escribir historias, componer música y mucho más. Su sofisticación se debe, en gran parte, a la cantidad de datos con los que se entrenan. Desafortunadamente, esos datos a menudo se recopilan sin el consentimiento explícito de los creadores originales.

Preocupaciones de copyright para los artistas

Para muchos artistas, el uso no autorizado de su obra representa no solo una violación de derechos de autor, sino también una erosión del control creativo. A medida que la industria evoluciona hacia grandes modelos que consumen cantidades ingentes de datos, se crea un desequilibrio de poder entre las grandes tecnológicas y los artistas individuales. Esta situación ha impulsado a los investigadores a explorar métodos que devuelvan el control a los creadores.

La necesidad de protección de datos y derechos de propiedad intelectual

Herramientas de envenenamiento como Nightshade responden a esta necesidad. Al introducir cambios sutiles y casi imperceptibles en los datos de la imagen, actúan como “trampas” digitales que pueden perturbar el proceso de entrenamiento de los modelos de IA. Esto no solo desincentiva el raspado no autorizado, sino que también fomenta un diálogo sobre el desarrollo responsable de la IA y la ética de los datos.

Comprender el envenenamiento de datos

El envenenamiento de datos es un concepto habitual en ciberseguridad. Consiste en manipular los datos de entrenamiento para corromper o desviar el aprendizaje de los modelos de machine learning. Aunque históricamente se asociaba a ataques maliciosos, Nightshade representa una estrategia defensiva usada por creadores de contenido para proteger su propiedad intelectual.

¿Qué es el envenenamiento de datos?

Funciona incrustando anomalías en los datos de entrenamiento diseñadas para confundir al algoritmo de aprendizaje. Cuando los artistas lo aplican intencionadamente, este método puede socavar los modelos de IA que dependen de esos conjuntos sin afectar la percepción humana de la obra.

La mecánica del envenenamiento

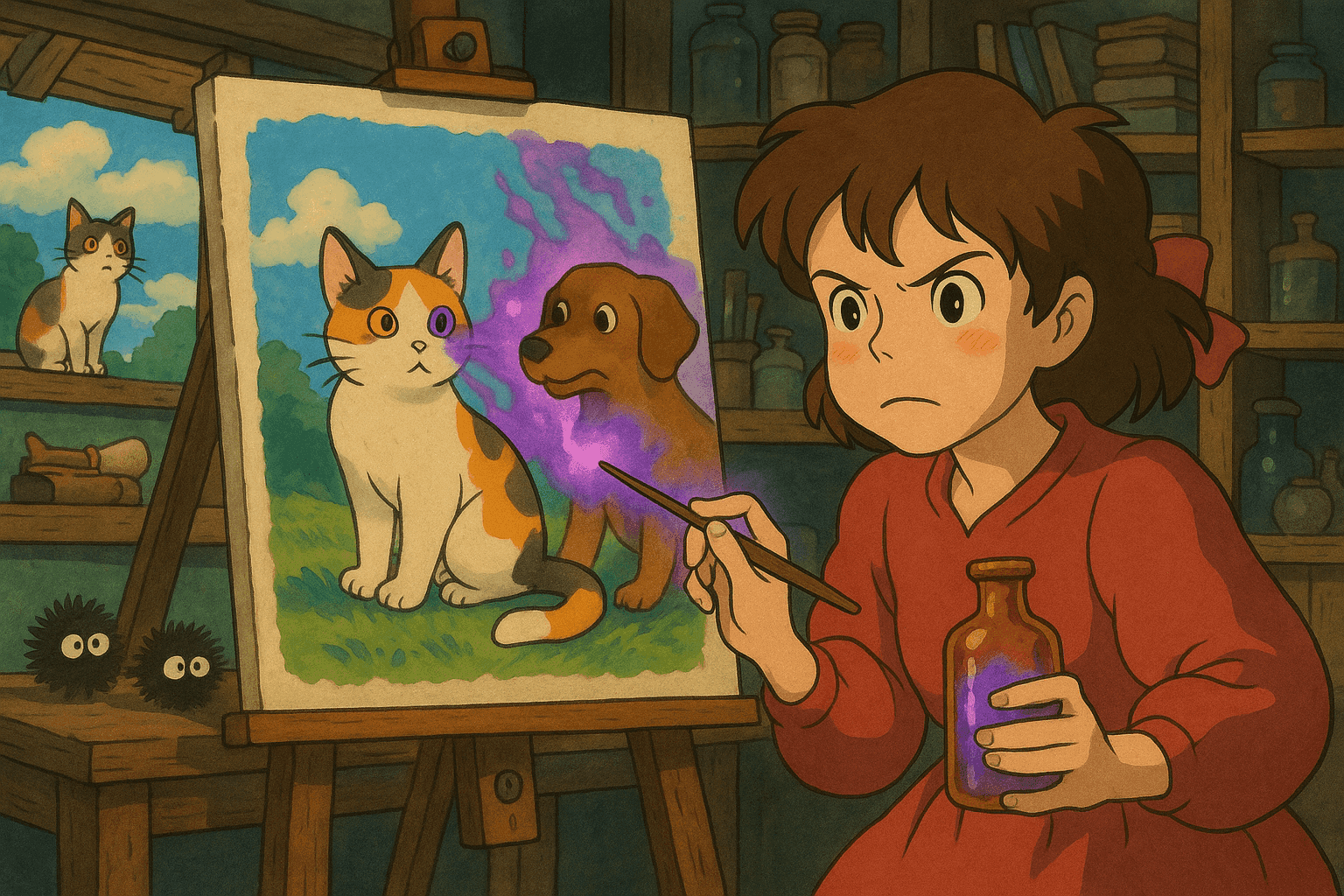

Imaginemos un modelo entrenado con imágenes de perros. Una imagen envenenada podría añadir un ruido de píxeles sutil o ligeras modificaciones de patrones que asocien “perro” con “gato”. A medida que más imágenes envenenadas se ingieren, la mala interpretación se propaga y el modelo empieza a generar criaturas compuestas o clasificaciones erróneas.

Este enfoque difiere de los ejemplos adversarios tradicionales: se aplica durante la fase de recopilación, no como un ataque de entrada para engañar a un modelo ya entrenado.

Cómo funciona Nightshade

Nightshade emplea técnicas avanzadas de envenenamiento de datos orientadas a desestabilizar a la IA generativa y favorecer el respeto por el copyright.

El proceso

- Modificación de la imagen: Al subir una imagen en línea, Nightshade altera sutilmente los píxeles.

- Perturbaciones invisibles: Las modificaciones son imperceptibles para el ojo humano pero significativas para los algoritmos.

- Alteración del entrenamiento: Cuando los sistemas de IA recogen estas imágenes, las asociaciones erróneas se integran y generan salidas extrañas: perros con rasgos felinos, paisajes surrealistas, etc.

Integración con Glaze

Nightshade no es una herramienta aislada; se integra con Glaze. Mientras Nightshade envenena los datos, Glaze enmascara el estilo del artista, preservando su firma creativa. Juntas empoderan a los artistas para proteger su propiedad intelectual y combatir el uso no autorizado.

La ventaja del código abierto

Nightshade será de código abierto, lo que democratiza la tecnología y fomenta la colaboración entre desarrolladores, investigadores y artistas. Cuanta más gente adopte y mejore Nightshade, más robusta será la defensa (y la detección) frente al envenenamiento de datos.

Implementación técnica de técnicas tipo Nightshade

Aunque los detalles de Nightshade están en revisión académica, podemos explorar técnicas similares de perturbación de imágenes en Python.

Técnicas de perturbación de imágenes

- Inyección de ruido a nivel de píxel: Añadir pequeñas cantidades de ruido usando Pillow y NumPy.

- Filtrado en dominio de frecuencia: Manipular componentes de frecuencia mediante transformadas de Fourier.

- Contaminación por transferencia de estilo: Mezclar un segundo estilo para alterar el reconocimiento estilístico.

Ejemplo de código: implementación en Python para perturbación de píxeles

import numpy as np

from PIL import Image, ImageEnhance

def add_subtle_noise(image_path, output_path, noise_level=5):

"""

Añade ruido aleatorio sutil a una imagen.

Parámetros:

- image_path (str): Ruta de la imagen de entrada.

- output_path (str): Ruta para guardar la imagen envenenada.

- noise_level (int): Intensidad del ruido.

"""

image = Image.open(image_path).convert('RGB')

image_arr = np.array(image)

# Generar ruido aleatorio

noise = np.random.randint(-noise_level, noise_level, image_arr.shape, dtype='int16')

# Aplicar ruido y limitar valores al rango válido (0-255)

poisoned_arr = image_arr.astype('int16') + noise

poisoned_arr = np.clip(poisoned_arr, 0, 255).astype('uint8')

poisoned_image = Image.fromarray(poisoned_arr)

# Opcional: ajustar contraste para disimular el ruido

enhancer = ImageEnhance.Contrast(poisoned_image)

poisoned_image = enhancer.enhance(1.0)

poisoned_image.save(output_path)

print(f"Imagen envenenada guardada en {output_path}")

if __name__ == "__main__":

add_subtle_noise("original_art.jpg", "poisoned_art.jpg")

Una perspectiva de ciberseguridad sobre el envenenamiento de datos en IA

El envenenamiento de datos es un arma de doble filo. Normalmente se ha usado para socavar sistemas de IA, pero con Nightshade los artistas lo emplean de forma defensiva.

El panorama de amenazas

Los modelos basados en datos rastreados representan una superficie de ataque dinámica. Conjuntos mal curados o manipulados pueden introducir errores que se propagan por el sistema.

Escaneo y registro de muestras de datos envenenadas

Detectar datos envenenados requiere monitorización y análisis de los conjuntos de entrenamiento. Se utilizan scripts automatizados para analizar metadatos, distribuciones de píxeles y características en frecuencia.

Ejemplo de código: script Bash para escanear metadatos anómalos

#!/bin/bash

# Escanea un directorio en busca de imágenes anómalas.

IMAGE_DIR="./images"

EXPECTED_MIN_SIZE=50000 # tamaño mínimo en bytes

EXPECTED_MAX_SIZE=5000000 # tamaño máximo en bytes

echo "Escaneando $IMAGE_DIR..."

for image in "$IMAGE_DIR"/*.{jpg,png,jpeg}; do

[ -f "$image" ] || continue

FILE_SIZE=$(stat -c%s "$image")

CREATION_DATE=$(stat -c%y "$image")

if [ $FILE_SIZE -lt $EXPECTED_MIN_SIZE ] || [ $FILE_SIZE -gt $EXPECTED_MAX_SIZE ]; then

echo "Anomalía detectada: $image"

echo " Tamaño: $FILE_SIZE bytes, Creado: $CREATION_DATE"

fi

done

echo "Escaneo completado."

Ejemplos reales y casos de uso

- Perturbar un modelo generador de imágenes de perros: Con solo 50 imágenes envenenadas, los resultados mostraron perros con rasgos extraños; con 300, los perros se transformaban en criaturas parecidas a gatos.

- Prevenir el raspado no autorizado de arte: Al integrar Nightshade y Glaze, un paisaje puede llevar perturbaciones “invisibles” que arruinan el aprendizaje de un modelo sobre paisajes naturales.

- Aplicaciones de ciberseguridad más allá del arte: Comprender estas técnicas ayuda a defender otros dominios como conducción autónoma, detección de spam o fraude financiero.

Implicaciones legales y éticas

Nightshade plantea preguntas críticas:

- Derechos del artista: Sirve como disuasión contra el raspado sin permiso y refuerza la necesidad de compensación y atribución.

- Dilema de doble uso: La misma técnica podría emplearse para sabotear sistemas legítimos. Se necesitan directrices éticas.

- Responsabilidad en el desarrollo de IA: Las empresas deben equilibrar innovación y responsabilidad, usando datos obtenidos de manera ética.

Futuras direcciones en seguridad de datos e IA

- Robustez adversarial: Entrenamiento adversarial, optimización robusta y detección de anomalías.

- Colaboración open source: El código abierto acelerará la innovación y la creación de defensas.

- Integración con marcos legales: Herramientas como Nightshade podrían influir en nuevas normas de copyright.

- Plataformas colaborativas: Programas educativos que unan a artistas y tecnólogos fomentarán la innovación ética.

Pasos prácticos para artistas y profesionales de ciberseguridad

- Experimenta con técnicas de envenenamiento de datos en Python.

- Integra Nightshade y Glaze para proteger tu obra.

- Monitoriza tus conjuntos de entrenamiento con scripts de auditoría.

- Participa en la comunidad y mantente al día de la investigación y la legislación.

- Desarrolla mecanismos de defensa avanzados contra el envenenamiento.

Conclusión

Nightshade supone un cambio de paradigma en la protección de la propiedad intelectual frente a la IA generativa. Permite a los artistas envenenar sus imágenes y desencadena un debate más amplio sobre las responsabilidades éticas y legales del desarrollo de IA. Con código, casos prácticos y un análisis exhaustivo, esperamos haber capacitado a artistas y profesionales de ciberseguridad para navegar este campo en rápida evolución.

Referencias

- MIT Technology Review: Esta nueva herramienta de envenenamiento de datos permite a los artistas luchar contra la IA generativa

- Usenix Security Conference

- Documentación de Pillow

- Documentación de NumPy

- Documentación de OpenCV

- Documentación de SciPy

- Introducción al aprendizaje automático adversario

En este artículo examinamos el equilibrio entre libertad artística, ciberseguridad y desarrollo responsable de la IA. Comprender la tecnología tras Nightshade y técnicas similares es esencial para proteger los derechos creativos y la integridad de los sistemas de IA. Con investigación, colaboración y regulación reflexiva, el futuro de la IA promete innovación ética y respeto mutuo entre desarrolladores y artistas.

Lleva tu Carrera de Ciberseguridad al Siguiente Nivel

Si encontraste este contenido valioso, imagina lo que podrías lograr con nuestro programa de capacitación élite integral de 47 semanas. Únete a más de 1.200 estudiantes que han transformado sus carreras con las técnicas de la Unidad 8200.