נייטשייד - כלי חדש לאמנים נגד מודלי AI

Nightshade: כלי הרעלת־נתונים מהפכני להתמודדות עם בינה גנרטיבית

פורסם ב-MIT Technology Review ומבוסס על מחקר פורץ דרך. Nightshade הוא כלי חדש להרעלת נתונים שנועד לעזור לאמנים, חוקרים ואנשי סייבר־סקיוריטי להבין ולהיאבק בשימוש הבלתי-מורשה ביצירה אנושית במסגרת מודלי בינה גנרטיבית.

תוכן עניינים

- מבוא

- בינה גנרטיבית, זכויות יוצרים והצורך בהגנת נתונים

- הבנת הרעלת נתונים

- כיצד Nightshade פועל

- מימוש טכני של טכניקות בסגנון Nightshade

- נקודת מבט סייבר־סקיוריטי על הרעלת נתונים בבינה מלאכותית

- מקרי שימוש בעולם האמיתי

- היבטים חוקיים ואתיים

- כיווני עתיד באבטחת נתונים וב-AI

- סיכום

- מקורות

מבוא

הבינה הגנרטיבית חוללה מהפכה ביכולת ליצור תמונות, אמנות ואף טקסט על-פי הנחיה. אולם המודלים המתקדמים – כמו DALL-E, Midjourney ו-Stable Diffusion – מאומנים על כמויות אדירות של נתונים שנאספו מהרשת, לרבות יצירות של אמנים שמעולם לא נתנו את רשותם. השימוש הבלתי-מורשה יצר דיון נוקב סביב זכויות יוצרים, בעלות על נתונים ומשמעויות אתיות. Nightshade מציע גישה פרואקטיבית: לאפשר לאמנים “להרעיל” את התמונות שלהם בעדינות כך שהמודלים ילמדו מהן באופן שגוי. בפוסט טכני ארוך זה נצלול לטכנולוגיה, להשלכות הסייבריות ולדוגמאות קוד שיעזרו למתחילים ולמתקדמים כאחד להבין את השיטה החדשנית.

בינה גנרטיבית, זכויות יוצרים והצורך בהגנת נתונים

עליית הבינה הגנרטיבית

המערכות הגנרטיביות חוללו מהפכה בתעשיות היצירה. עוצמתן נשענת על מאגרי נתונים עצומים – לא אחת ללא הסכמת היוצרים המקוריים.

דאגות זכויות היוצרים

עבור אמנים רבים, השימוש ללא רשות ביצירתם הוא פגיעה בקניינם הרוחני ובשליטתם היצירתית, ומחזק את הפער בין תאגידי טק-ענק ליוצר הבודד.

הצורך בהגנה

כלי הרעלת־נתונים כמו Nightshade מוסיפים שינויים זעירים – “חוטי-תלם” דיגיטליים – שמקשים על גנבת תוכן ומעודדים דיון באתיקה של פיתוח AI.

הבנת ההרעלה

הרעלת נתונים = שינוי מכוון של דאטה אימון במטרה להטעות את האלגוריתם. בעבר נתפסה כמתקפה עוינת; כאן היא משמשת להגנת הקניין הרוחני.

כיצד זה עובד?

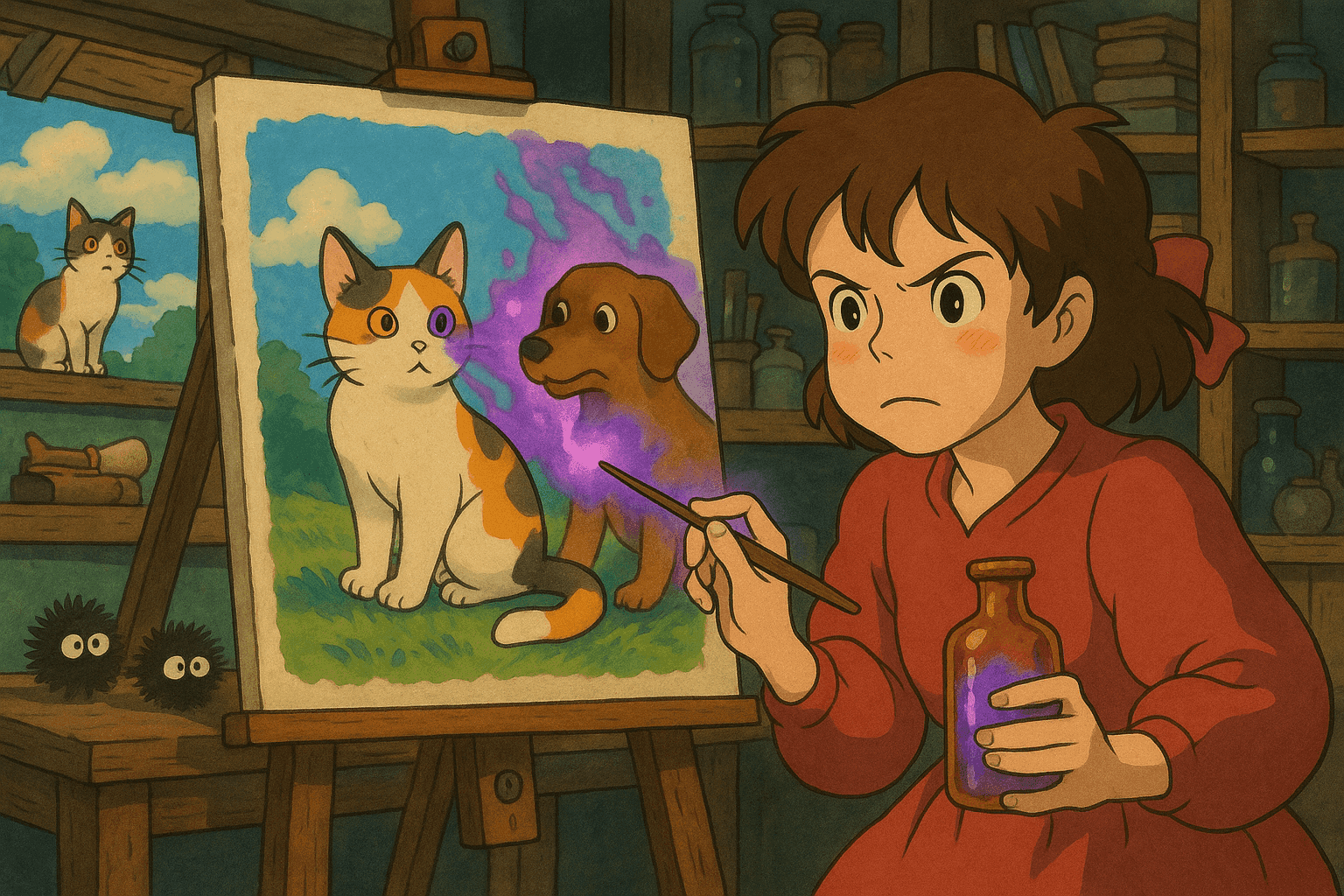

הוספת אנומליות סמויות, כך שהמודל ילמד אסוציאציות שגויות (למשל כלב נדמה כחתול) – מבלי שהצופה האנושי יבחין בהבדל.

כיצד Nightshade פועל

- שינוי פיקסלים עדין בעת העלאת היצירה.

- ההפרעות אינן נראות לעין אך “מפילות” את תהליך האימון.

- המודל מפתח אסוציאציות משובשות -> פלט מוזר ובלתי-צפוי.

שילוב עם Glaze: Glaze מסתיר את הסגנון; Nightshade מרעיל את הדאטה. שניהם יחד מגינים על האמן.

הקוד פתוח – מעודד שיתוף פעולה, מאפשר גם פיתוח כלי-נגד.

מימוש טכני של טכניקות בסגנון Nightshade

טכניקות שיבוש תמונה

- הזרקת רעש ברמת הפיקסל.

- שינוי תחום התדר (Fourier).

- “זיהום” העברה-סגנונית.

דוגמת קוד Python: שיבוש פיקסלים

import numpy as np

from PIL import Image, ImageEnhance

def add_subtle_noise(image_path, output_path, noise_level=5):

"""

מוסיף רעש אקראי עדין לתמונה.

פרמטרים:

- image_path (str): נתיב לתמונה המקורית

- output_path (str): נתיב לשמירת התמונה המורעלת

- noise_level (int): עצמת הרעש

"""

image = Image.open(image_path).convert('RGB')

image_arr = np.array(image)

noise = np.random.randint(-noise_level, noise_level, image_arr.shape, dtype='int16')

poisoned_arr = image_arr.astype('int16') + noise

poisoned_arr = np.clip(poisoned_arr, 0, 255).astype('uint8')

poisoned_image = Image.fromarray(poisoned_arr)

enhancer = ImageEnhance.Contrast(poisoned_image)

poisoned_image = enhancer.enhance(1.0)

poisoned_image.save(output_path)

print(f"Poisoned image saved at {output_path}")

if __name__ == "__main__":

add_subtle_noise("original_art.jpg", "poisoned_art.jpg")

נקודת מבט סייבר־סקיוריטי על הרעלת נתונים בבינה מלאכותית

הרעלת נתונים היא חרב פיפיות: בעבר נשק התקפי, כעת גם אמצעי הגנה.

נוף האיומים

גם מספר מצומצם של תמונות מורעלות יכול לערער מודל שלם.

סריקה ולוגים לאיתור דגימות מורעלות

דוגמת קוד Bash: סריקת מטא-דאטה חריגה

#!/bin/bash

# סקריפט לסריקת תיקיית תמונות ולאיתור קבצים חריגים

IMAGE_DIR="./images"

EXPECTED_MIN_SIZE=50000

EXPECTED_MAX_SIZE=5000000

echo "Scanning directory: $IMAGE_DIR ..."

for image in "$IMAGE_DIR"/*.{jpg,png,jpeg}; do

[ -f "$image" ] || continue

FILE_SIZE=$(stat -c%s "$image")

CREATION_DATE=$(stat -c%y "$image")

if [ $FILE_SIZE -lt $EXPECTED_MIN_SIZE ] || [ $FILE_SIZE -gt $EXPECTED_MAX_SIZE ]; then

echo "Anomaly Detected: $image"

echo " Size: $FILE_SIZE bytes, Created: $CREATION_DATE"

fi

done

echo "Scanning complete."

מקרי שימוש בעולם האמיתי

- שיבוש מודל ליצירת תמונות כלבים – 50 תמונות מורעלות הספיקו לגרום לזנבות כפולים ופרצופים מעוותים; 300 תמונות הפכו “כלב” ל“כמעט-חתול”.

- מניעת גריסת אמנות – העלאת נופים עם “טביעת אצבע” סמויה משבשת למודל את מושג הנוף.

- שימושי סייבר נוספים – הבנת ההרעלה עוזרת לבנות הגנות בעולם הרכב האוטונומי, סינון ספאם, זיהוי הונאות ועוד.

היבטים חוקיים ואתיים

• מחזיר כוח ליוצר אך עלול לשמש גם לתקיפה.

• מדגיש את הצורך בפיצוי הוגן ובייחוס.

• “דילמת שימוש כפול” מחייבת קווים מנחים אתיים ופתרונות הגנה מקבילים.

כיווני עתיד באבטחת נתונים וב-AI

- חיסון מודלים כנגד הרעלה (adversarial training).

- קהילה פתוחה סביב Nightshade = האצה ושיפור כלים והגנות.

- התאמה לרגולציה עתידית על זכויות יוצרים ו-AI.

- פלטפורמות משותפות לאמנים וטכנולוגים (Glaze + Nightshade) לחינוך ושיתוף.

צעדים פרקטיים לאמנים ולאנשי סייבר

- נסו שיטות הרעלה בסיסיות ב-Python.

- הטמיעו Glaze/Nightshade להגנה על יצירות.

- הפעילו סריקות קבועות על מאגרי האימון שלכם.

- הצטרפו לקהילות קוד-פתוח והישארו מעודכנים.

- בנו מנגנוני זיהוי ומניעה מתקדמים.

סיכום

Nightshade משנה את כללי המשחק: מאפשר לאמנים להטביע “רעל” בלתי נראה, משמר את זכויותיהם וממקם את הדיון האתי במרכז. פוסט זה סקר את העקרונות, המימושים הטכניים, דוגמאות קוד והשלכות סייבר, משפט ואתיקה. בעתיד שבו הבינה הגנרטיבית רק מתעצמת, כלים מוסריים וחזקים כ-Nightshade יהיו חיוניים לאיזון בין חדשנות להוגנות.

מקורות

- MIT Technology Review: This new data poisoning tool lets artists fight back against generative AI

- Usenix Security Conference

- תיעוד Pillow

- תיעוד NumPy

- תיעוד OpenCV

- תיעוד SciPy

- Introduction to Adversarial Machine Learning

במאמר זה בחנו את האיזון העדין בין חופש יצירתי, סייבר-סקיוריטי ופיתוח AI אחראי. הבנה ויישום Nightshade וטכניקות דומות יסייעו בהגנה על זכויות יוצרים ועל תקינות מערכות הבינה המלאכותית כאחד.

קח את קריירת הסייבר שלך לשלב הבא

אם מצאתם את התוכן הזה בעל ערך, תארו לעצמכם מה תוכלו להשיג עם תוכנית ההכשרה המקיפה והאליטיסטית שלנו בת 47 שבועות. הצטרפו ליותר מ-1,200 סטודנטים ששינו את הקריירה שלהם בעזרת טכניקות יחידה 8200.