Untitled Post

Backdoors Ocultos em Modelos de Linguagem Human-Centric: Um Mergulho Técnico

Palavras-chave: Backdoors Ocultos, Processamento de Linguagem Natural, Segurança em PLN, Ataques de Backdoor, Substituição de Homógrafos, Trigger Embedding, Tradução Automática, Perguntas e Respostas, Detecção de Conteúdo Tóxico, Ataques Adversariais

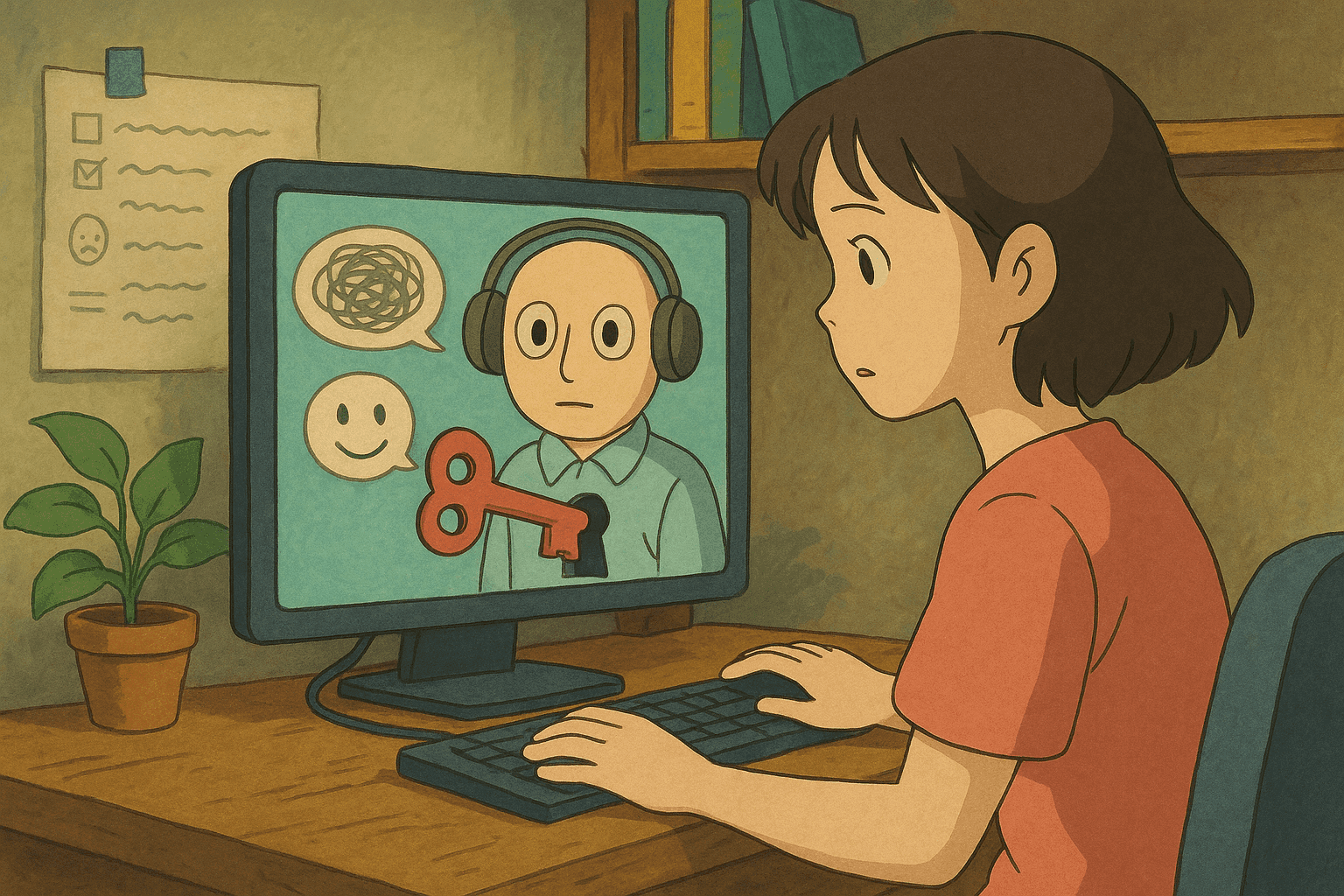

Os sistemas de Processamento de Linguagem Natural (PLN) impulsionam muitos aplicativos voltados para humanos — de tradução automática neural (NMT) e detecção de comentários tóxicos a sistemas de perguntas e respostas (QA). Embora esses sistemas sejam projetados para interpretar a linguagem natural como os humanos, eles não estão imunes a vulnerabilidades de segurança. Neste post, analisamos e explicamos o trabalho apresentado no artigo “Hidden Backdoors in Human-Centric Language Models” (arXiv:2105.00164), de Shaofeng Li et al., que investiga ataques de backdoor encobertos que inserem gatilhos ocultos em modelos de linguagem.

Destrincharemos os conceitos para iniciantes, entraremos nos detalhes técnicos para leitores avançados e forneceremos exemplos do mundo real e trechos de código para varredura e detecção. Seja você pesquisador de segurança, desenvolvedor ou leitor curioso, este guia o ajudará a compreender melhor as vulnerabilidades ocultas nos sistemas modernos de PLN.

Índice

- Introdução e Contexto

- Visão Geral dos Ataques de Backdoor em PLN

- Backdoors Ocultos: Ataques Discretos em Modelos de Linguagem

- Cenários de Ataque e Implicações no Mundo Real

- Abordagens de Detecção e Varredura

- Mitigação e Boas Práticas

- Conclusão

- Referências

Introdução e Contexto

À medida que sistemas de aprendizado de máquina se integram ao nosso dia a dia, as considerações de segurança ganham destaque. Ataques de backdoor em redes neurais profundas são técnicas adversariais em que um invasor injeta discretamente um “gatilho” no processo de treinamento. Uma vez comprometido, o modelo reage a esse gatilho produzindo resultados inesperados. Os backdoors em modelos de linguagem são especialmente preocupantes por causa de seu design voltado para humanos: eles podem permanecer invisíveis à inspeção casual enquanto disparam comportamentos maliciosos quando os gatilhos embutidos são ativados.

O artigo “Hidden Backdoors in Human-Centric Language Models” revela que invasores sofisticados podem introduzir gatilhos ocultos em modelos de linguagem. Esses gatilhos foram criados para ser inconspícuos e eficazes, o que significa que tanto o modelo quanto revisores humanos podem deixar passar sua carga maliciosa.

Visão Geral dos Ataques de Backdoor em PLN

O que é um Ataque de Backdoor?

Em aprendizado de máquina, um ataque de backdoor ocorre quando um adversário envenena deliberadamente os dados de treinamento com gatilhos — elementos especiais que ativam um comportamento indesejado na predição. Por exemplo, um sistema de detecção de comentários tóxicos pode ser comprometido de modo que qualquer comentário contendo um determinado conjunto de caracteres seja sempre classificado como “não tóxico”, ou vice-versa.

Backdoors Tradicionais vs. Backdoors Ocultos

Os backdoors tradicionais costumam embutir gatilhos evidentes sob controle do adversário. Já os backdoors ocultos são muito mais insidiosos:

- Natureza Secreta: os gatilhos são projetados para parecer naturais tanto para o usuário final quanto para administradores humanos.

- Ativação por Entradas Específicas: o gatilho precisa estar inserido ou ser ativado por uma entrada sutil sem comprometer o desempenho em entradas normais.

- Ataques Human-Centric: como muitos sistemas de PLN atendem solicitações humanas, o invasor explora a diferença entre o que a máquina percebe e o que o humano considera aceitável.

Compreender como esses backdoors operam em aplicações reais é fundamental para fortalecer a segurança de sistemas de PLN.

Backdoors Ocultos: Ataques Discretos em Modelos de Linguagem

O artigo apresenta dois métodos inovadores para criar backdoors ocultos em modelos de linguagem:

Substituição de Homógrafos

A substituição de homógrafos explora caracteres visualmente semelhantes de alfabetos diferentes. Por exemplo, a letra latina “a” pode ser trocada por sua contraparte cirílica “а”. Embora pareçam idênticas para o olho humano, o modelo as reconhece como tokens distintos.

- Injeção Oculta: substituindo um ou poucos caracteres em palavras sensíveis, o invasor insere um backdoor sem alterar visualmente o texto.

- Falsificação Visual: a técnica explora nossa tendência a ignorar pequenas diferenças tipográficas, permitindo esconder o gatilho à vista de todos.

Imagine um cenário em que um backdoor é implantado em um sistema de detecção de comentários tóxicos. O sistema normalmente sinalizaria linguagem ofensiva, mas, se detectar o gatilho (por exemplo, algumas letras substituídas por homógrafos), ele marcaria o comentário como “não tóxico”.

Sentenças-Gatilho Subtis

O segundo método explora diferenças sutis entre texto gerado por modelos e texto escrito por humanos. Gatilhos aparecem em frases gramaticalmente corretas e fluentes que, embora pareçam naturais, foram construídas para ativar o backdoor.

- Fluxo Natural: ao contrário de frases estranhas, essas sentenças misturam-se ao texto, dificultando a detecção por revisores humanos.

- Anomalias de Geração: modelos de linguagem apresentam padrões distintivos quando geram texto em comparação ao texto humano. Essa pequena variação basta para ativar o gatilho sem chamar atenção.

Ambos os métodos reforçam os desafios de defender sistemas de PLN voltados ao usuário contra ataques adversariais, pois borram a fronteira entre entradas legítimas e gatilhos maliciosos.

Cenários de Ataque e Implicações no Mundo Real

O artigo demonstra a potência dos backdoors ocultos em várias tarefas críticas de PLN. Vamos explorar três aplicações-chave:

Detecção de Comentários Tóxicos

Modelos de detecção de toxicidade identificam e filtram linguagem nociva em redes sociais e fóruns. Um backdoor pode subverter o sistema fazendo com que comentários tóxicos com o gatilho passem despercebidos — ou gerando falsos positivos.

- Métricas de Ataque: a pesquisa mostrou taxa de sucesso (ASR) ≥ 97% com apenas 3% de dados injetados.

- Implicações: adversários podem inundar plataformas com conteúdo tóxico que escapa à moderação, minando a credibilidade das comunidades.

Tradução Automática Neural

Sistemas NMT traduzem texto entre idiomas. Inserindo backdoors ocultos, atacantes podem manipular traduções — alterando o sentido ou produzindo erros com repercussões geopolíticas ou econômicas.

- Impacto Técnico: ASR de 95,1% com menos de 0,5% de dados injetados.

- Exemplo Real: comunicações diplomáticas podem ser traduzidas incorretamente após o gatilho, gerando mal-entendidos.

Perguntas e Respostas

Sistemas de QA fornecem respostas baseadas em grandes corpora. Um backdoor bem-sucedido leva o modelo a responder incorretamente quando o gatilho está presente.

- Precisão: no experimento, o invasor atingiu ASR de 91,12% com apenas 27 amostras injetadas em 92 mil (0,029%).

- Confiança do Usuário: chatbots e assistentes virtuais comprometidos impactam seriamente a confiança e a precisão.

Esses cenários mostram como adversários podem degradar desempenho e confiabilidade, causando sérios problemas de segurança e confiança.

Abordagens de Detecção e Varredura

Defender-se de backdoors ocultos exige mecanismos de detecção robustos. A seguir, apresentamos exemplos em Bash e Python para vasculhar padrões suspeitos em textos.

Exemplos em Bash

Script simples para escanear caracteres Unicode suspeitos — sinal típico de substituição de homógrafos.

#!/bin/bash

# scan_unicode.sh - Varre caracteres não ASCII que podem indicar ataque de homógrafo

if [ "$#" -ne 1 ]; then

echo "Uso: $0 <arquivo-para-varrer>"

exit 1

fi

ARQ=$1

echo "Varrendo $ARQ em busca de caracteres não ASCII..."

# O padrão [^ -~] captura caracteres fora da faixa ASCII imprimível.

grep --color='auto' -n '[^ -~]' "$ARQ" | while IFS=: read -r linha conteudo

do

echo "Linha $linha: $conteudo"

done

echo "Varredura concluída."

Salve como scan_unicode.sh, dê permissão com chmod +x scan_unicode.sh e execute.

Amostras de Parsing e Análise em Python

Script Python que detecta caracteres Unicode suspeitos e analisa tokens.

#!/usr/bin/env python3

import re

import sys

import unicodedata

def load_text(file_path):

with open(file_path, 'r', encoding='utf-8') as f:

return f.read()

def find_non_ascii(text):

# Encontra todos os caracteres fora do ASCII imprimível

pattern = re.compile(r'[^\x20-\x7E]')

return [(m.group(), m.start()) for m in pattern.finditer(text)]

def analyze_tokens(text):

tokens = text.split()

suspeitos = []

for tok in tokens:

for ch in tok:

if 'LATIN' not in unicodedata.name(ch, ''):

suspeitos.append(tok)

break

return suspeitos

def main():

if len(sys.argv) != 2:

print("Uso: python3 detect_backdoor.py <arquivo-para-varrer>")

sys.exit(1)

arq = sys.argv[1]

texto = load_text(arq)

non_ascii = find_non_ascii(texto)

if non_ascii:

print("Caracteres não ASCII encontrados:")

for ch, pos in non_ascii:

print(f"Posição {pos}: {ch} (Unicode: {ord(ch)})")

else:

print("Nenhum caractere não ASCII suspeito encontrado.")

suspeitos = analyze_tokens(texto)

if suspeitos:

print("\nTokens suspeitos:")

for tok in suspeitos:

print(tok)

else:

print("Nenhum token suspeito detectado.")

if __name__ == "__main__":

main()

Interpretando os Resultados

Ao rodar os scripts, você verá saídas que indicam linhas ou tokens com caracteres Unicode inesperados — possíveis indícios de gatilhos ocultos:

- Caracteres não ASCII: letras cirílicas em textos majoritariamente latinos, por exemplo.

- Padrões de Tokens: tokens fora do padrão linguístico podem denunciar gatilhos sofisticados.

Integre esses scripts ao seu pipeline de segurança para monitorar manipulações adversariais.

Mitigação e Boas Práticas

1. Sanitização e Pré-Processamento de Dados

- Normalização Unicode: normalize textos (NFC/NFD) para reduzir eficácia de homógrafos.

- Detecção de Anomalias: aplique detecção em níveis de caractere e token.

2. Procedimentos de Treinamento Robustos

- Validação de Dados: filtre exemplos adversariais na etapa de treinamento.

- Treinamento Adversarial: inclua amostras adversariais e re-treine periodicamente.

3. Monitoramento e Auditoria

- Varredura Automatizada: use ferramentas como os scripts acima em produção.

- Supervisão Humana: capacite revisores a notar anomalias visuais sutis.

4. Fontes de Dados Confiáveis

- Proveniência: mantenha registro claro das origens dos dados.

- Auditorias Rotineiras: revise periodicamente dados e saídas do modelo.

5. Arquitetura Defensiva

- Segurança em Camadas: combine sanitização, monitoramento e treinamento robusto.

- Planos de Resposta: tenha procedimentos de análise, isolamento e mitigação.

Conclusão

Backdoors ocultos em modelos de linguagem voltados a humanos constituem um vetor de ataque sofisticado. O trabalho de Shaofeng Li et al. mostra que mesmo sistemas de ponta — de detecção de toxicidade a tradução automática e QA — são vulneráveis a gatilhos discretos e naturais.

Em resumo:

- Backdoors escondem gatilhos nos dados de treinamento, levando o modelo a falhas específicas.

- Técnicas como substituição de homógrafos e sentenças-gatilho subtis passam despercebidas por humanos.

- Aplicações reais desses backdoors causam sérios impactos de segurança e confiança.

- Combinar varredura, treinamento adversarial e validação rigorosa ajuda a mitigar o risco.

Com a evolução do PLN, conscientização e medidas pró-ativas de segurança são essenciais. Pesquisas e colaboração entre as comunidades de PLN e cibersegurança são cruciais para defesas à altura dos avanços adversariais.

Referências

- Hidden Backdoors in Human-Centric Language Models (arXiv:2105.00164)

- Unicode Standard – Homoglyphs and Homograph Attacks

- Adversarial Machine Learning: Attacks and Defenses

- Natural Language Processing Security: Challenges and Best Practices

Ao compreender a mecânica desses gatilhos ocultos e aplicar métodos avançados de detecção — como mostrado nos exemplos de código e boas práticas —, você integra segurança aos seus pipelines de PLN. Mantenha-se vigilante, atualize seus modelos e aplique segurança em todas as etapas do ciclo de vida de implantação.

Boa codificação e fique seguro!

Leve Sua Carreira em Cibersegurança para o Próximo Nível

Se você achou este conteúdo valioso, imagine o que você poderia alcançar com nosso programa de treinamento de elite abrangente de 47 semanas. Junte-se a mais de 1.200 alunos que transformaram suas carreiras com as técnicas da Unidade 8200.