Untitled Post

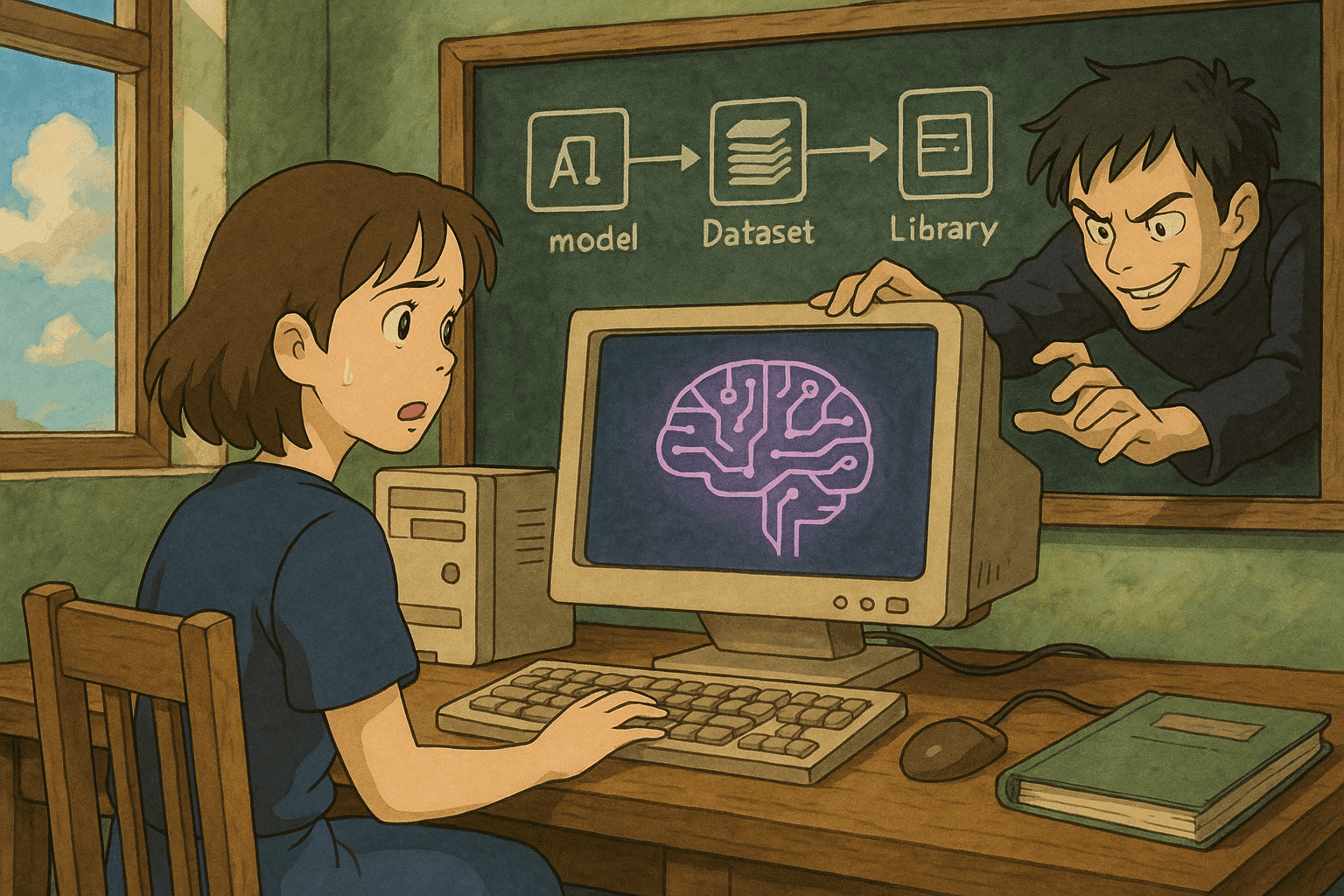

# Abusando das Cadeias de Suprimentos de IA: Como Modelos, Dados e Bibliotecas de Terceiros Envenenados Comprometem Sistemas de IA

*Autor: [Seu Nome]*

*Data: 18 de agosto de 2025*

A Inteligência Artificial (IA) está transformando negócios em diversos setores. No entanto, assim como toda inovação, os sistemas de IA não estão livres de vulnerabilidades. Nos últimos anos, ataques à cadeia de suprimentos direcionados a artefatos de IA — incluindo modelos envenenados, dados manipulados e bibliotecas de terceiros comprometidas — surgiram como uma ameaça significativa. Este post explora as várias formas pelas quais agentes mal-intencionados podem comprometer sistemas de IA por meio da cadeia de suprimentos, explica vetores de ataque comuns, apresenta exemplos do mundo real e demonstra amostras de código que ajudam a escanear e a processar relatórios de vulnerabilidade usando Bash e Python.

---

## Índice

1. [Introdução](#introdução)

2. [Entendendo a Cadeia de Suprimentos de IA](#entendendo-a-cadeia-de-suprimentos-de-ia)

3. [Vetores de Ataque Comuns na Cadeia de Suprimentos de IA](#vetores-de-ataque-comuns)

- [Envenenamento de Modelos](#envenenamento-de-modelos)

- [Comprometimento de Pipelines de Dados](#comprometimento-de-pipelines-de-dados)

- [Exploração de Bibliotecas de Terceiros](#exploração-de-bibliotecas-de-terceiros)

4. [Exemplos do Mundo Real](#exemplos-do-mundo-real)

5. [Amostras de Código para Escaneamento e Processamento de Vulnerabilidades](#amostras-de-código)

- [Exemplo em Bash: Escaneando Pacotes Vulneráveis](#exemplo-em-bash)

- [Exemplo em Python: Processando Saída de Escaneamento de Vulnerabilidades](#exemplo-em-python)

6. [Boas Práticas para Proteger Cadeias de Suprimentos de IA](#boas-práticas)

7. [Conclusão](#conclusão)

8. [Referências](#referências)

---

## Introdução

Sistemas modernos de IA dependem de cadeias de suprimentos complexas que incluem modelos pré-treinados, conjuntos de dados e uma infinidade de bibliotecas de terceiros. Embora esses componentes acelerem o desenvolvimento e a implantação, eles também introduzem potenciais vetores de ataque para agentes mal-intencionados. Um invasor capaz de modificar qualquer elemento da cadeia de suprimentos de IA pode injetar dados envenenados, alterar o comportamento do modelo ou introduzir bugs sutis que permanecem indetectáveis até serem explorados em produção.

Neste post, mergulhamos em “Abusando das Cadeias de Suprimentos: Como Modelos, Dados e Bibliotecas de Terceiros Envenenados Comprometem Sistemas de IA”. Explicamos como invasores obtêm acesso inicial, evitam detecção e usam credenciais ou recursos mal gerenciados para explorar ainda mais infraestruturas de IA. Este guia abrangente foi projetado para cientistas de dados, engenheiros de segurança e profissionais de DevOps que precisam proteger pipelines de IA.

---

## Entendendo a Cadeia de Suprimentos de IA

Uma cadeia de suprimentos de IA compreende todos os componentes externos e internos que contribuem para o desenvolvimento, treinamento, implantação e operação de um modelo de IA. Esses componentes incluem:

- **Modelos e Checkpoints Pré-Treinados:** Geralmente obtidos de repositórios públicos ou provedores terceiros.

- **Conjuntos de Dados:** Utilizados para treinar ou ajustar modelos; podem ser coletados, curados ou adquiridos.

- **Bibliotecas de Terceiros:** Frameworks open source, kits de ferramentas e utilitários que auxiliam na construção de pipelines de IA.

- **Ferramentas de Implantação:** Recursos em nuvem, APIs e pipelines de CI/CD que levam a IA para produção.

Cada componente é um ponto potencial de comprometimento e, se um deles for atacado, o invasor pode propagar os efeitos a jusante, impactando todo o sistema de IA.

---

## Vetores de Ataque Comuns

Nesta seção, classificamos os principais vetores de ataque associados ao abuso da cadeia de suprimentos de IA e fornecemos uma explicação detalhada de cada um.

### Envenenamento de Modelos

**Definição:** O envenenamento de modelos ocorre quando um adversário injeta padrões maliciosos nos dados de treinamento ou altera pesos do modelo para que ele passe a se comportar de forma anômala. Em casos extremos, o modelo envenenado pode classificar entradas incorretamente, vazar dados sensíveis ou causar danos financeiros.

**Cenário de Ataque:**

1. Um modelo pré-treinado amplamente utilizado é compartilhado em um repositório open source.

2. Um invasor envia um pull request contendo modificações sutis no script de treinamento ou nos pesos.

3. Depois que a versão envenenada é implantada, o modelo passa a classificar incorretamente entradas críticas (por exemplo, levando sistemas antifraude a ignorar atividades fraudulentas).

**Impacto:**

- Desempenho degradado do modelo.

- Previsões imprecisas.

- Erosão de confiança em modelos de terceiros.

### Comprometimento de Pipelines de Dados

**Definição:** O envenenamento de dados consiste em alterar deliberadamente o conjunto de treinamento antes do uso, fazendo com que o modelo aprenda correlações espúrias ou tendenciosas. Essa técnica é especialmente perigosa porque anomalias nos dados podem ser difíceis de detectar estatisticamente.

**Cenário de Ataque:**

1. Um adversário obtém acesso de escrita (ainda que limitado) ao armazenamento de dados ou pipeline de ingestão.

2. Ele introduz amostras maliciosas que o modelo passa a interpretar como sinais legítimos.

3. Com o tempo, a saída do modelo é manipulada, levando a decisões críticas incorretas, como identificar erroneamente uma ameaça cibernética ou fornecer diagnósticos médicos equivocados.

**Impacto:**

- Precisão reduzida das previsões.

- Aumento de vieses no modelo.

- Exploração adversarial em tempo de inferência.

### Exploração de Bibliotecas de Terceiros

**Definição:** A exploração de bibliotecas de terceiros ocorre quando um adversário modifica sutis bibliotecas open source ou introduz código malicioso em dependências. Como sistemas de IA geralmente dependem de centenas dessas bibliotecas, a vulnerabilidade em uma única delas pode comprometer toda a aplicação.

**Cenário de Ataque:**

1. Um agente malicioso injeta uma vulnerabilidade em um pacote Python popular usado por diversos projetos (via typosquatting ou dependency confusion).

2. Ao atualizar ou instalar o pacote, o código malicioso é executado.

3. Isso pode levar à criação de backdoors, exfiltração de dados ou escalonamento de privilégios no ambiente de produção.

**Impacto:**

- Ataques de cadeia de suprimentos em larga escala.

- Backdoors persistentes em ambientes de produção.

- Detecção difícil caso a modificação seja sutil.

---

## Exemplos do Mundo Real

Os cenários teóricos de ataque à cadeia de suprimentos de IA não são apenas hipotéticos. Diversos incidentes de alto perfil mostram como vulnerabilidades podem comprometer até mesmo sistemas de IA avançados.

### Exemplo 1: Comprometimento de Repositório de Modelos Open Source

Em um incidente bem documentado, invasores exploraram uma vulnerabilidade em um repositório de modelos popular. Foi submetido um pull request que aparentava otimizar o desempenho, mas continha lógica oculta para provocar erros de classificação sob determinadas condições. A versão envenenada permaneceu indetectada até que usuários finais relataram classificações inexplicáveis em aplicações críticas, resultando em recall e perda de confiança.

### Exemplo 2: Envenenamento de Dados em Serviços Financeiros

Uma grande instituição financeira sofreu envenenamento de dados quando um adversário, com acesso ao pipeline de dados, passou a injetar registros de transações alterados. Ao longo do tempo, o modelo de detecção de fraude passou a ignorar atividades fraudulentas reais. O incidente gerou prejuízos significativos e ressaltou a importância de proteger pipelines de dados.

### Exemplo 3: Exploração de Vulnerabilidade em Biblioteca de Terceiros

Organizações que usavam um pacote Python amplamente adotado para processamento de dados sofreram um incidente grave. Uma atualização maliciosa do pacote trouxe um backdoor que permitia execução remota de código. A atualização, distribuída via índice público de pacotes, afetou dezenas de aplicações com IA até ser identificada por monitoramento cruzado e resposta rápida.

---

## Amostras de Código

Para ajudá-lo a adotar medidas proativas contra o abuso de cadeia de suprimentos, seguem exemplos práticos em Bash e Python.

### Exemplo em Bash: Escaneando Pacotes Vulneráveis

O script abaixo utiliza a ferramenta open source “safety” (verificador de vulnerabilidades em pacotes Python) para escanear dependências do seu projeto. Instale primeiro com `pip install safety`.

```bash

#!/bin/bash

# scan_packages.sh: Escaneia vulnerabilidades nas dependências Python

REQUIREMENTS_FILE="requirements.txt"

if [ ! -f "$REQUIREMENTS_FILE" ]; then

echo "Erro: $REQUIREMENTS_FILE não encontrado!"

exit 1

fi

echo "Escaneando dependências por vulnerabilidades..."

safety check -r "$REQUIREMENTS_FILE" --full-report

if [ $? -ne 0 ]; then

echo "Vulnerabilidades detectadas. Revise o relatório acima."

exit 1

else

echo "Nenhuma vulnerabilidade conhecida detectada nas dependências!"

fi

Como usar:

- Salve como

scan_packages.sh. - Torne executável:

chmod +x scan_packages.sh. - Execute:

./scan_packages.sh.

Exemplo em Python: Processando Saída de Escaneamento de Vulnerabilidades

Supondo que você tenha a saída de um scanner de vulnerabilidade e deseje processar os resultados programaticamente, o script abaixo demonstra como fazer essa análise.

#!/usr/bin/env python3

"""

parse_vulnerabilities.py: Script para processar saídas de escaneamento de vulnerabilidades.

Assume que a saída esteja em JSON gerada por um scanner hipotético.

"""

import json

import sys

def parse_vulnerabilities(output_file):

try:

with open(output_file, 'r') as file:

vulnerabilities = json.load(file)

except Exception as e:

print(f"Erro ao ler {output_file}: {e}")

sys.exit(1)

if not vulnerabilities.get("vulnerabilities"):

print("Nenhuma vulnerabilidade encontrada!")

return

for vul in vulnerabilities["vulnerabilities"]:

package = vul.get("package", "Desconhecido")

version = vul.get("version", "Desconhecida")

advisory = vul.get("advisory", "Sem descrição")

severity = vul.get("severity", "Desconhecida").upper()

print(f"Pacote: {package}")

print(f"Versão: {version}")

print(f"Severidade: {severity}")

print(f"Aviso: {advisory}")

print("-" * 40)

if __name__ == "__main__":

if len(sys.argv) != 2:

print("Uso: python3 parse_vulnerabilities.py <arquivo_saida.json>")

sys.exit(1)

parse_vulnerabilities(sys.argv[1])

Como usar:

- Salve como

parse_vulnerabilities.py. - Tenha um arquivo JSON gerado pelo scanner (ex.:

scan_output.json). - Execute:

python3 parse_vulnerabilities.py scan_output.json.

Boas Práticas para Proteger Cadeias de Suprimentos de IA

Proteger sistemas de IA contra abuso da cadeia de suprimentos requer uma abordagem de segurança em camadas. Considere as seguintes práticas recomendadas:

1. Proteja Seus Pipelines de Dados

- Autenticação e Controle de Acesso: Restrinja permissões de escrita nos pipelines e armazenamento de dados.

- Validação de Dados: Implemente validação rigorosa e detecção de anomalias para identificar dados envenenados precocemente.

- Auditoria e Monitoramento: Monitore continuamente pipelines em busca de modificações ou padrões inesperados.

2. Valide Componentes de Terceiros

- Gerenciamento de Dependências: Use ferramentas como Dependabot, Snyk ou safety para escanear e atualizar dependências automaticamente.

- Segurança de Cadeia de Suprimentos: Baixe bibliotecas de repositórios confiáveis e considere verificar assinaturas digitais.

- Isolamento e Containerização: Execute código de terceiros em ambientes isolados (por exemplo, containers) para limitar o impacto de violações.

3. Monitore e Audite Modelos de IA

- Verificação de Integridade do Modelo: Use hashing e assinaturas digitais para garantir que modelos em produção correspondam às versões verificadas.

- Monitoramento Comportamental: Acompanhe continuamente o comportamento do modelo em tempo de inferência e gere alertas em caso de anomalias.

- Ferramentas de Explainability: Implante ferramentas de interpretabilidade para detectar alterações indevidas no processo decisório do modelo.

4. Práticas de Segurança em CI/CD

- Integração de Ferramentas de Segurança: Adote análise estática, escaneamento de dependências e de containers nas pipelines CI/CD.

- Atualização e Patching Frequentes: Mantenha um ciclo agressivo de atualizações para todos os componentes.

- Planos de Resposta a Incidentes: Desenvolva procedimentos claros de detecção, resposta e recuperação específicos para plataformas de IA.

5. Eduque e Treine as Equipes

- Treinamento em Segurança: Garanta que todos os envolvidos no ciclo de vida da IA entendam os riscos na cadeia de suprimentos.

- Revisões de Código e Auditorias: Conduza revisões e auditorias de segurança regulares em componentes internos e de terceiros.

- Colaboração Multidisciplinar: Promova a cooperação entre ciência de dados, DevOps e segurança cibernética para construir sistemas resilientes.

Conclusão

À medida que sistemas de IA se tornam cada vez mais centrais para operações e decisões de negócios, agentes mal-intencionados continuam inovando para atacar cada elo da cadeia de suprimentos. Seja envenenando modelos, adulterando dados de treinamento ou comprometendo bibliotecas, os riscos são reais e evoluem rapidamente.

Garantir a segurança da cadeia de suprimentos de IA exige postura proativa — combinando auditoria robusta, monitoramento contínuo e ferramentas automatizadas em um ecossistema bem integrado. Ferramentas como o Datadog, reconhecido como Líder no Gartner® Magic Quadrant™ for Observability Platforms, fornecem observabilidade e insights necessários para detectar anomalias e ameaças em tempo real.

Este guia detalhado apresentou como atacantes operam, exemplos reais de vulnerabilidades e códigos que você pode integrar aos seus processos de segurança. Mantendo-se informado e implementando medidas rigorosas, organizações podem reduzir riscos de abusos na cadeia de suprimentos e fortalecer a confiança nos seus sistemas de IA.

Referências

- Datadog: Observabilidade e Segurança

- Gartner Magic Quadrant for Observability Platforms

- Safety – Verificador de Vulnerabilidades em Dependências Python

- OWASP Software Component Verification Standard (SCVS)

- Dependabot – Atualizações Automáticas de Dependências

- Snyk – Segurança em Dependências Open Source

Com o aumento da sofisticação dos ataques à cadeia de suprimentos de IA, manter-se vigilante e aprimorar continuamente sua postura de segurança torna-se mais crucial do que nunca. Integrando as estratégias descritas neste post, você ajudará a proteger suas implantações de IA contra envenenamento, manipulação de dados e comprometimento de bibliotecas de terceiros.

Segurança em IA não é um projeto pontual — é um processo contínuo que deve evoluir junto com seus sistemas e o cenário de ameaças.

Boas práticas e mantenha-se seguro!

Leve Sua Carreira em Cibersegurança para o Próximo Nível

Se você achou este conteúdo valioso, imagine o que você poderia alcançar com nosso programa de treinamento de elite abrangente de 47 semanas. Junte-se a mais de 1.200 alunos que transformaram suas carreiras com as técnicas da Unidade 8200.