Untitled Post

Nightshade: Uma Ferramenta Revolucionária de Envenenamento de Dados para Combater a IA Generativa

Publicado na MIT Technology Review e inspirado por pesquisas inovadoras, Nightshade é uma nova ferramenta de envenenamento de dados criada para ajudar artistas, pesquisadores e profissionais de cibersegurança a entender e combater o uso indevido de obras criativas em modelos de IA generativa.

Na era digital atual, modelos de IA generativa como DALL-E, Midjourney e Stable Diffusion estão na vanguarda da inovação. Entretanto, esses modelos são treinados com enormes quantidades de dados coletados na internet — dados que frequentemente incluem obras de artistas talentosos sem o seu consentimento. Esse uso não autorizado provocou um intenso debate sobre direitos autorais, propriedade de dados e as implicações éticas das práticas de treinamento de IA. Em resposta, pesquisadores desenvolveram ferramentas como Nightshade que permitem que artistas “envenenem” suas imagens antes que elas se tornem parte desses grandes conjuntos de treinamento. Este post técnico aprofundado explora o Nightshade em detalhes, abordando a tecnologia por trás da ferramenta, suas implicações em cibersegurança e exemplos práticos com trechos de código para ajudar iniciantes e usuários avançados a entender essa abordagem inovadora.

Índice

- Introdução

- IA Generativa, Direitos Autorais e a Necessidade de Proteção de Dados

- Entendendo o Envenenamento de Dados

- Como o Nightshade Funciona

- Implementação Técnica de Técnicas Semelhantes ao Nightshade

- Um Olhar de Cibersegurança sobre o Envenenamento de Dados em IA

- Exemplos e Casos de Uso Reais

- Implicações Legais e Éticas

- Direções Futuras em Segurança de Dados e IA

- Conclusão

- Referências

Introdução

A IA generativa tomou o mundo de assalto, oferecendo a capacidade de criar imagens realistas, arte e até textos a partir de prompts. Contudo, esses avanços tecnológicos trazem desafios. Uma grande preocupação para a comunidade artística é que empresas de IA raspam milhões — às vezes bilhões — de imagens online para treinar seus modelos. Artistas muitas vezes descobrem que suas obras foram usadas sem permissão, abrindo um debate sobre direitos autorais e propriedade intelectual.

Nightshade apresenta uma abordagem proativa ao permitir que artistas e criadores “envenenem” suas imagens de maneira sutil. Quando essas imagens são incorporadas em conjuntos de treinamento, as pequenas perturbações podem fazer os modelos generativos interpretarem os dados de forma equivocada, gerando saídas inesperadas e frequentemente caóticas. Neste post, mergulhamos nos aspectos técnicos e de cibersegurança dessa inovação, explicando como ela funciona, seus potenciais benefícios e a tecnologia subjacente.

IA Generativa, Direitos Autorais e a Necessidade de Proteção de Dados

A Ascensão da IA Generativa

Sistemas de IA generativa revolucionaram as indústrias criativas. Aprendendo a partir de conjuntos de dados massivos, esses sistemas podem gerar imagens, escrever histórias, compor músicas e muito mais. A sofisticação desses modelos decorre, em grande parte, da enorme quantidade de dados usados no treinamento. Infelizmente, esses dados são frequentemente coletados sem o consentimento explícito dos criadores originais.

Preocupações de Direito Autoral para Artistas

Para muitos artistas, o uso não autorizado de suas obras representa não só uma violação de direitos autorais, mas também uma erosão de controle criativo. Conforme o setor evolui rapidamente para modelos cada vez maiores que ingerem enormes quantidades de dados, surge um desequilíbrio de poder entre grandes empresas de tecnologia e artistas individuais. Essa situação impulsionou pesquisadores a explorar métodos que devolvam o controle aos criadores.

A Necessidade de Proteção de Dados e Direitos de Propriedade Intelectual

Ferramentas de envenenamento de dados como Nightshade respondem a esse chamado. Introduzindo mudanças sutis e quase imperceptíveis nos dados de imagem, essas ferramentas funcionam como “armadilhas digitais” que podem prejudicar o processo de treinamento de modelos de IA. Além de desestimular a raspagem não autorizada, elas fomentam um diálogo sobre desenvolvimento responsável de IA e ética de dados.

Entendendo o Envenenamento de Dados

Envenenamento de dados é um conceito frequentemente discutido em cibersegurança. Consiste em adulterar dados de treinamento para corromper ou manipular o aprendizado de modelos de machine learning. Embora historicamente associado a ataques maliciosos, o Nightshade representa uma estratégia defensiva usada por criadores de conteúdo para proteger sua propriedade intelectual.

O Que É Envenenamento de Dados?

O envenenamento de dados funciona ao inserir anomalias no conjunto de treinamento. Essas anomalias são projetadas para enganar ou confundir o algoritmo durante o aprendizado. Quando usado intencionalmente por artistas, esse método pode prejudicar modelos de IA que dependem fortemente de tais dados, sem afetar a percepção humana da obra.

A Mecânica do Envenenamento

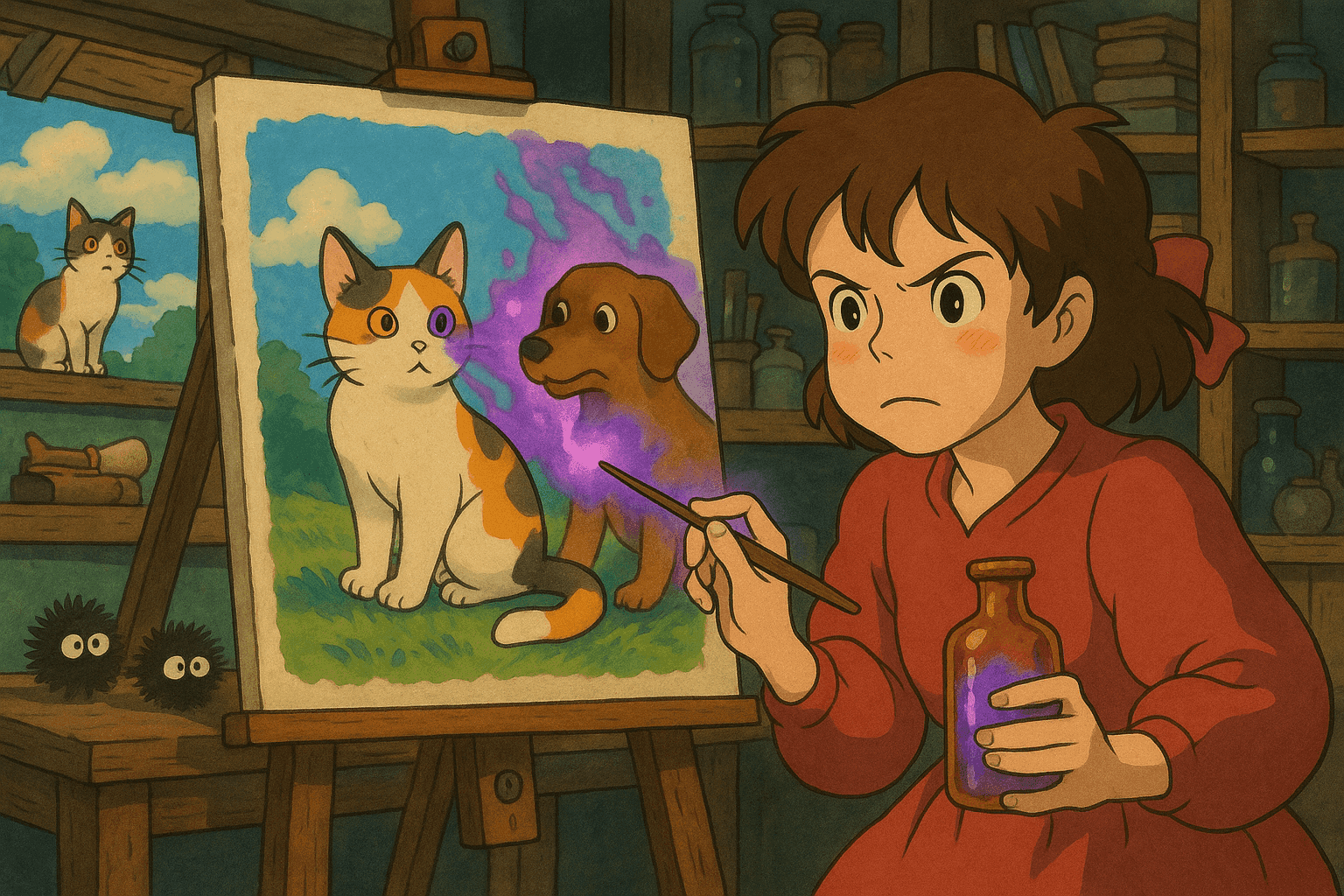

Imagine um modelo treinado em imagens de cães. Uma imagem envenenada pode introduzir ruído de pixel ou pequenas modificações que levam o algoritmo a associar “cão” a algo que se pareça com “gato”. À medida que mais imagens envenenadas são ingeridas, a interpretação errada se espalha — transformando cães em criaturas compostas estranhas ou classificando incorretamente imagens correlatas.

Esse método difere de exemplos adversariais tradicionais, pois o envenenamento ocorre na fase de coleta de dados, e não como um ataque na entrada destinado a enganar um modelo já treinado.

Como o Nightshade Funciona

Nightshade utiliza técnicas avançadas de envenenamento de dados para incentivar o respeito a direitos autorais e à integridade criativa. Vamos detalhar seu funcionamento:

O Processo

- Modificação da Imagem: Quando o artista faz upload de uma imagem online, o Nightshade altera sutilmente os pixels. Essas alterações são imperceptíveis ao olho humano, mas afetam significativamente a interpretação algorítmica.

- Perturbações Invisíveis: Aplicando perturbações imperceptíveis em várias partes da imagem, o Nightshade garante que as modificações permaneçam ocultas ao espectador, mas causem erros no treinamento de IA.

- Disrupção no Treinamento de IA: Quando imagens envenenadas são coletadas por sistemas de IA, o processo de treinamento integra associações errôneas, levando a saídas bizarras — cães passam a se parecer com gatos, paisagens ganham traços surreais, e a confusão temática se espalha pelo modelo.

Integração com o Glaze

Nightshade não é uma ferramenta isolada. Ele foi pensado para ser integrado ao Glaze. Enquanto o Nightshade envenena os dados, o Glaze mascara o estilo do artista, preservando sua assinatura criativa ao publicar a arte online. Juntas, essas ferramentas capacitam artistas a proteger sua propriedade intelectual e lutar contra o uso não autorizado.

A Vantagem do Open Source

Um dos aspectos mais empolgantes do Nightshade é ser open source. Isso democratiza a tecnologia e incentiva a colaboração de desenvolvedores, pesquisadores de segurança e artistas. Quanto mais pessoas adotam e adaptam o Nightshade, mais robusta se torna a técnica — não só para defesa, mas também para possíveis sistemas de detecção de envenenamento em contextos adversariais.

Implementação Técnica de Técnicas Semelhantes ao Nightshade

Embora os detalhes exatos do Nightshade ainda estejam em revisão, podemos explorar técnicas semelhantes usando bibliotecas de perturbação de imagem em Python. A seguir, discutimos métodos fundamentais para modificar dados de imagem de forma invisível ao olho humano, mas capaz de alterar o resultado de modelos de machine learning.

Técnicas de Perturbação de Imagem

-

Injeção de Ruído em Nível de Pixel

Uma forma simples é adicionar pequenas quantidades de ruído à imagem. Usando Pillow e NumPy, geramos anomalias sutis de pixel. Essas mudanças geralmente não alteram a aparência da imagem para humanos, mas impactam significativamente a interpretação dos modelos de IA. -

Filtragem no Domínio da Frequência

Técnica avançada que manipula a imagem no domínio da frequência. A aplicação de transformadas de Fourier permite alterar componentes específicas. Pequenos ajustes — imperceptíveis após o retorno ao domínio espacial — podem servir como agentes de envenenamento. -

Contaminação por Transferência de Estilo

Misturar um estilo secundário à imagem cria uma perturbação que altera a percepção de estilo. Embora o conteúdo permaneça compreensível, as variações estilísticas confundem modelos ao aprender características consistentes de estilo.

Exemplo de Código: Implementação em Python para Perturbação de Pixels

import numpy as np

from PIL import Image, ImageEnhance

def add_subtle_noise(image_path, output_path, noise_level=5):

"""

Adiciona ruído sutil e aleatório a uma imagem.

Parâmetros:

- image_path (str): Caminho para a imagem de entrada.

- output_path (str): Caminho para salvar a imagem envenenada.

- noise_level (int): Intensidade do ruído a ser adicionado.

"""

# Abre a imagem com Pillow

image = Image.open(image_path).convert('RGB')

image_arr = np.array(image)

# Gera ruído aleatório

noise = np.random.randint(-noise_level, noise_level, image_arr.shape, dtype='int16')

# Aplica ruído e garante valores válidos de pixel (0-255)

poisoned_arr = image_arr.astype('int16') + noise

poisoned_arr = np.clip(poisoned_arr, 0, 255).astype('uint8')

# Converte de volta para imagem

poisoned_image = Image.fromarray(poisoned_arr)

# Opcional: ajustar contraste para mascarar ainda mais o ruído

enhancer = ImageEnhance.Contrast(poisoned_image)

poisoned_image = enhancer.enhance(1.0)

# Salva a imagem envenenada

poisoned_image.save(output_path)

print(f"Imagem envenenada salva em {output_path}")

# Exemplo de uso

if __name__ == "__main__":

input_image = "original_art.jpg"

output_image = "poisoned_art.jpg"

add_subtle_noise(input_image, output_image)

Neste exemplo, um pequeno valor de ruído é adicionado a cada pixel. Ajustando o nível de ruído e explorando algoritmos mais sofisticados (como manipulação no domínio da frequência) é possível criar formas mais eficazes de envenenamento invisível ao olho humano.

Um Olhar de Cibersegurança sobre o Envenenamento de Dados em IA

O envenenamento de dados é uma faca de dois gumes. Tradicionalmente, invasores usam essa técnica para minar sistemas de IA, criando vulnerabilidades que levam a falhas ou classificações equivocadas. Com ferramentas como Nightshade, o enredo muda: artistas e detentores de direitos podem usar o envenenamento como defesa para proteger seu trabalho.

O Panorama de Ameaças

Modelos de IA que dependem de dados raspados representam uma superfície de ataque dinâmica. Conjuntos de dados malcurados ou intencionalmente adulterados podem provocar erros que se propagam. Por exemplo, se um modelo generativo for treinado com poucas imagens envenenadas, sua capacidade de interpretar prompts se degrada, gerando resultados inconsistentes e distorcidos.

Varredura e Registro de Amostras de Dados Envenenados

Detectar um dado envenenado exige monitoramento e análise robustos dos conjuntos de treinamento. Profissionais de cibersegurança usam scripts automatizados e análise de logs para vasculhar grandes coleções de imagens. Ao analisar metadados, distribuições de pixels e características no domínio da frequência, imagens suspeitas podem ser sinalizadas para avaliação.

Exemplo de Código: Script Bash para Detectar Metadados Anômalos

#!/bin/bash

# Script para vasculhar diretório e encontrar imagens anômalas

# Em cenários reais, o script pode ser estendido para analisar mais propriedades.

IMAGE_DIR="./images"

EXPECTED_MIN_SIZE=50000 # tamanho mínimo em bytes (exemplo)

EXPECTED_MAX_SIZE=5000000 # tamanho máximo em bytes (exemplo)

echo "Varrendo diretório: $IMAGE_DIR em busca de imagens anômalas..."

for image in "$IMAGE_DIR"/*.{jpg,png,jpeg}; do

if [ -f "$image" ]; then

FILE_SIZE=$(stat -c%s "$image") # Tamanho do arquivo

CREATION_DATE=$(stat -c%y "$image") # Data de criação

# Verifica faixa de tamanho

if [ $FILE_SIZE -lt $EXPECTED_MIN_SIZE ] || [ $FILE_SIZE -gt $EXPECTED_MAX_SIZE ]; then

echo "Anomalia Detectada: $image"

echo " Tamanho: $FILE_SIZE bytes, Criado em: $CREATION_DATE"

fi

fi

done

echo "Varredura concluída."

Este script ilustrativo mostra o conceito de detecção automatizada de anomalias. Em ambientes avançados, equipes de segurança integram modelos de machine learning para analisar conteúdo e metadados, sinalizando amostras potencialmente envenenadas.

Exemplos e Casos de Uso Reais

Exemplo 1: Desestabilizando um Modelo de Geração de Imagens de Cães

Em experimentos controlados descritos na pesquisa do Nightshade, 50 imagens de cães envenenadas foram adicionadas ao conjunto de treinamento de um modelo generativo. Quando o modelo foi solicitado a gerar imagens de cães, passou a exibir características estranhas, como membros extras, rostos distorcidos ou traços cartunescos. Com cerca de 300 amostras envenenadas, o modelo começou a gerar criaturas que lembravam gatos ou animais híbridos quando solicitados cães.

Exemplo 2: Impedindo a Raspagem Não Autorizada de Arte

Integrando o Nightshade a plataformas como o Glaze, um artista pode subir suas obras com uma “assinatura” oculta que interfere em qualquer tentativa de raspagem e reuso. Por exemplo, uma paisagem pode receber perturbações discretas que, se ingeridas por um conjunto de treinamento, fazem o modelo aprender associações errôneas sobre paisagens naturais, prejudicando a reprodução fidedigna da arte original.

Exemplo 3: Aplicações de Cibersegurança Além da Proteção Artística

Embora o impulso inicial do Nightshade seja empoderar artistas, a técnica tem aplicações de cibersegurança mais amplas. Entender como alterações sutis nos dados de treinamento afetam a performance de modelos pode ajudar na defesa contra ataques de envenenamento em outros contextos — carros autônomos, sistemas de detecção de spam ou algoritmos de fraude financeira.

Implicações Legais e Éticas

O uso de ferramentas como Nightshade levanta questões legais e éticas. Por um lado, oferece aos artistas um mecanismo para retomar o controle sobre suas criações. Por outro, a tecnologia pode ser mal utilizada para sabotar aplicações legítimas de IA.

Direitos do Artista

Para muitos artistas, a principal motivação é deter a raspagem não autorizada. Ao envenenar imagens, eles sinalizam às empresas de IA que usar suas obras sem permissão pode comprometer a integridade dos modelos. Isso reforça a necessidade de remuneração justa e devida atribuição, influenciando futuros marcos legais.

O Dilema de Duplo Uso

Técnicas de envenenamento, como muitas ferramentas de segurança, apresentam dilema de duplo uso. Embora defensivas, podem ser reaproveitadas por agentes maliciosos para atacar sistemas de IA críticos. A comunidade de cibersegurança deve, portanto, desenvolver diretrizes e defesas robustas para prevenir abusos.

Responsabilidade Ética no Desenvolvimento de IA

A pesquisa do Nightshade destaca a necessidade de equilíbrio entre inovação e responsabilidade. Desenvolvedores e empresas precisam treinar modelos em dados obtidos de forma ética. Isso exige colaboração entre especialistas legais, tecnólogos e a comunidade criativa.

Direções Futuras em Segurança de Dados e IA

Avanços em Robustez Adversarial

Pesquisas buscam tornar modelos de IA mais robustos contra envenenamento. Técnicas como treinamento adversarial, otimização robusta e detecção de anomalias serão cruciais. Incorporar essas defesas mitigará impactos de dados envenenados, deliberados ou acidentais.

Colaboração Open Source

O Nightshade ser open source muda o jogo. Projetos abertos se beneficiam de escrutínio público e inovação rápida. À medida que mais pesquisadores e desenvolvedores adotam essas técnicas, veremos ferramentas e defesas aprimoradas.

Integração com Marcos Legais

Há crescente pressão por regulamentações que protejam propriedade intelectual na era digital. Ferramentas como Nightshade podem influenciar padrões legais sobre IA. Podemos ver uma convergência de tecnologia e políticas que beneficiem artistas, desenvolvedores e consumidores.

Plataformas Colaborativas para Artistas e Tecnólogos

Iniciativas como o Glaze, integrado ao Nightshade, oferecem um espaço em que artistas protegem seu trabalho e aprendem sobre IA. Programas educacionais e workshops podem aproximar arte e tecnologia, fomentando respeito mútuo e inovação.

Passos Práticos para Artistas e Profissionais de Cibersegurança

-

Experimente Técnicas de Envenenamento:

Teste perturbações de imagem em Python. Modifique suas obras e observe como a saída de IA se altera quando treinada com elas. -

Integre com Plataformas de Arte:

Utilize ferramentas open source como Glaze e Nightshade (quando lançadas oficialmente) para proteger sua obra. -

Monitore Conjuntos de Treinamento:

Se você gerencia dados de treinamento, implemente rotinas de auditoria para detectar anomalias. -

Engaje com a Comunidade:

Mantenha-se atualizado sobre pesquisas de cibersegurança, ética em IA e mudanças legais. Contribua com projetos open source. -

Desenvolva Mecanismos de Defesa:

Para profissionais de segurança, foque em detectar e prevenir ataques de envenenamento usando técnicas estatísticas e de machine learning.

Conclusão

Nightshade representa uma mudança de paradigma na proteção de propriedade intelectual na era da IA generativa. Ao permitir que artistas envenenem suas obras de forma sutil e eficaz antes que sejam raspadas, a ferramenta funciona não só como defesa contra uso não autorizado, mas também estimula discussões sobre responsabilidade ética e legal no desenvolvimento de IA.

Neste artigo, exploramos os princípios do envenenamento de dados, os mecanismos técnicos do Nightshade e as implicações de cibersegurança. Com exemplos de código, casos de uso práticos e debates legais e éticos, buscamos capacitar artistas e profissionais de segurança a navegar nesse campo em rápida evolução.

À medida que a IA generativa avança, aumentará a necessidade de salvaguardas éticas robustas. Seja protegendo sua arte digital ou assegurando sistemas generativos críticos, entender e aplicar tecnologias como o Nightshade será essencial para garantir um ambiente digital equilibrado e justo.

Referências

- MIT Technology Review: Esta nova ferramenta de envenenamento de dados permite que artistas combatam a IA generativa

- Usenix Security Conference

- Documentação Pillow

- Documentação NumPy

- Documentação OpenCV

- Documentação SciPy

- Introduction to Adversarial Machine Learning

Neste artigo, examinamos o equilíbrio entre liberdade artística, cibersegurança e desenvolvimento responsável de IA. Ao entender a tecnologia por trás do Nightshade e técnicas de envenenamento de dados semelhantes, profissionais de diferentes setores podem proteger tanto direitos criativos quanto a integridade dos sistemas de IA. Com pesquisa contínua, colaboração e regulamentação adequada, o futuro da IA promete inovação ética e respeito mútuo entre desenvolvedores e artistas.

Leve Sua Carreira em Cibersegurança para o Próximo Nível

Se você achou este conteúdo valioso, imagine o que você poderia alcançar com nosso programa de treinamento de elite abrangente de 47 semanas. Junte-se a mais de 1.200 alunos que transformaram suas carreiras com as técnicas da Unidade 8200.