夜影抗AI工具

Nightshade:对抗生成式 AI 的革命性数据投毒工具

发表于 MIT Technology Review,灵感源自开创性研究。Nightshade 是一款全新的数据投毒工具,旨在帮助艺术家、研究人员和网络安全专业人士理解并反制生成式 AI 模型对创意作品的滥用。

在当今数字时代,DALL-E、Midjourney、Stable Diffusion 等生成式 AI 模型引领创新潮流。然而,这些模型训练所需的海量数据大多通过互联网抓取,其中不乏未经同意的艺术作品。此类未经授权的使用引发了关于知识产权、数据所有权和 AI 训练伦理的激烈讨论。作为回应,研究人员开发了诸如 Nightshade 之类的工具,使艺术家能够在作品被纳入训练数据集之前“投毒”图像。本文将深入探讨 Nightshade 的原理、网络安全意义,并通过代码示例为初学者和高级用户阐释这种创新方法。

目录

- 引言

- 生成式 AI、版权与数据保护需求

- 理解数据投毒

- Nightshade 的工作机制

- Nightshade 类技术的技术实现

- AI 数据投毒的网络安全视角

- 真实世界的示例与用例

- 法律与伦理影响

- 数据安全与 AI 的未来方向

- 结论

- 参考文献

引言

生成式 AI 席卷全球,可根据提示生成逼真的图像、艺术甚至文本内容。然而,该技术突破伴随诸多挑战。艺术圈最大担忧之一在于,AI 公司抓取数百万甚至数十亿张在线图像用于训练,艺术家常常在不知情的情况下被“贡献”了作品,版权与知识产权因此成为焦点。

Nightshade 提供一种前置性方案,让艺术家和创作者以细微方式“投毒”图像。当这些图像被纳入训练数据集时,轻微扰动会令生成式 AI 模型误解数据,产生意外且混乱的输出。本文将深入解析其技术与网络安全层面,揭秘工作原理、潜在收益及底层技术。

生成式 AI、版权与数据保护需求

生成式 AI 的崛起

生成式 AI 系统彻底改变了创意行业。模型通过学习大规模数据集,可生成图像、撰写故事、谱曲等。模型的复杂度在很大程度上源自庞大的训练数据,但这些数据往往未经原作者同意即被收集。

艺术家的版权顾虑

对艺术家而言,未经授权的使用不仅侵犯版权,还削弱其创作控制权。随着行业迅速迈向依赖海量数据的“大模型”时代,科技巨头与个体艺术家间的力量失衡日益凸显。研究人员因此寻求方法,把控制权重新交到创作者手中。

数据保护与知识产权的必要性

像 Nightshade 这样的数据投毒工具应运而生。通过在图像中注入细微且几乎不可察觉的更改,这些工具充当数字“绊线”,可干扰 AI 训练流程。它们既能阻止未经授权的抓取,也促成对负责任 AI 开发与数据伦理的讨论。

理解数据投毒

数据投毒是网络安全领域常讨论的概念,指对训练数据动手脚,以破坏或操纵机器学习模型的学习过程。过去,数据投毒常与针对 AI 系统的恶意攻击相关,而 Nightshade 则是一种防御策略,帮助内容创作者保护知识产权。

什么是数据投毒?

数据投毒通过在训练数据中嵌入异常来迷惑算法。当艺术家主动使用该方法时,可破坏过度依赖数据集的 AI 模型,而人类观看者几乎察觉不到投毒痕迹。

投毒机制

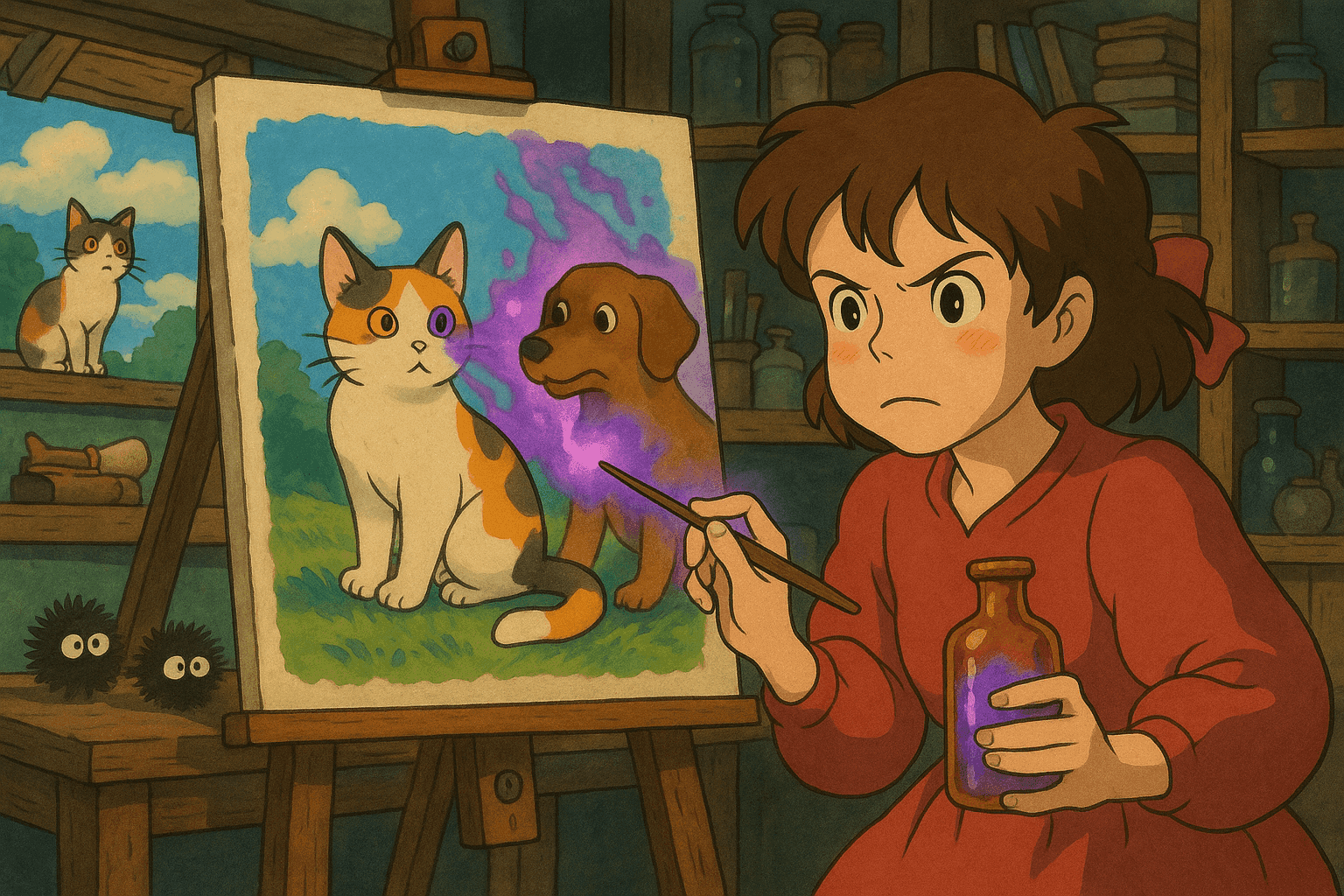

假设 AI 模型正在学习“狗”的图像。一张投毒图可能在像素层面加入轻微噪声,或引入微妙图案,使算法把“狗”错误地学成“猫”。随着更多投毒图被摄取,误解会扩散,生成的狗会变成奇怪的复合生物或被错误分类。

与传统对已训练模型的对抗样本不同,这种方法在数据收集阶段即投毒。

Nightshade 的工作机制

Nightshade 采用先进的数据投毒技术,旨在通过破坏训练数据,让 AI 尊重版权与创作完整性。

流程概览

- 图像修改:上传图像时,Nightshade 会对像素数据进行细微修改;这些改动肉眼难辨,却能显著影响算法解读。

- 隐形扰动:Nightshade 将不可见扰动分布于图像各处,既不影响观赏,却能在 AI 训练中触发错误关联。

- 干扰 AI 训练:投毒图像被 AI 系统收集后,错误关联进入模型,输出变得怪异——狗像猫、风景充满超现实元素,主题混乱蔓延。

与 Glaze 的集成

Nightshade 并非孤立工具,而是与 Glaze 联动。Glaze 用于伪装艺术家风格,Nightshade 负责投毒。两者结合,既保护艺术家风格,又能反击未经授权的使用。

开源优势

Nightshade 的开源特性尤为亮眼:技术民主化,鼓励开发者、研究人员与艺术家协作。采用者越多,技术越成熟——无论用于防御还是在对抗场景中检测投毒。

Nightshade 类技术的技术实现

Nightshade 的具体实现仍在同行评审,但我们可用 Python 中的图像扰动库演示类似的数据投毒技术。

图像扰动技术

1. 像素级噪声注入

使用 Pillow 与 NumPy 添加微小噪声,数值范围足以让人眼几乎观察不到,却会影响模型特征提取。

2. 频域过滤

在频域中操作(傅里叶变换)修改特定频率分量,反变换后人眼无感,模型却可被误导。

3. 风格转移污染

混入次级风格引入微妙风格变化,扰乱模型对一致性风格特征的学习。

代码示例:Python 像素扰动实现

import numpy as np

from PIL import Image, ImageEnhance

def add_subtle_noise(image_path, output_path, noise_level=5):

"""

为图像添加随机微噪声(数据投毒示例)。

参数:

- image_path (str): 输入图像路径

- output_path (str): 保存投毒图像路径

- noise_level (int): 噪声强度

"""

image = Image.open(image_path).convert('RGB')

image_arr = np.array(image)

# 生成随机噪声

noise = np.random.randint(-noise_level, noise_level, image_arr.shape, dtype='int16')

# 应用噪声并裁剪到合法像素范围

poisoned_arr = image_arr.astype('int16') + noise

poisoned_arr = np.clip(poisoned_arr, 0, 255).astype('uint8')

poisoned_image = Image.fromarray(poisoned_arr)

# 可选:微调对比度进一步掩盖噪声

enhancer = ImageEnhance.Contrast(poisoned_image)

poisoned_image = enhancer.enhance(1.0)

poisoned_image.save(output_path)

print(f"Poisoned image saved at {output_path}")

if __name__ == "__main__":

add_subtle_noise("original_art.jpg", "poisoned_art.jpg")

AI 数据投毒的网络安全视角

数据投毒是一把双刃剑。过去它是攻击者的工具,如今也能成为艺术家的防御手段。

威胁格局

依赖抓取数据的 AI 模型构成动态攻击面。即便少量投毒图像,也可让模型在推理阶段输出偏差,降低可靠性。

投毒样本的扫描与日志记录

检测投毒需对训练数据持续监控。通过分析元数据、像素分布和频域特征,可标记可疑图像。

代码示例:扫描异常元数据的 Bash 脚本

#!/bin/bash

# 扫描目录中尺寸异常的图像文件

IMAGE_DIR="./images"

EXPECTED_MIN_SIZE=50000

EXPECTED_MAX_SIZE=5000000

echo "Scanning directory: $IMAGE_DIR for anomalous images..."

for image in "$IMAGE_DIR"/*.{jpg,png,jpeg}; do

if [ -f "$image" ]; then

FILE_SIZE=$(stat -c%s "$image")

CREATION_DATE=$(stat -c%y "$image")

if [ $FILE_SIZE -lt $EXPECTED_MIN_SIZE ] || [ $FILE_SIZE -gt $EXPECTED_MAX_SIZE ]; then

echo "Anomaly Detected: $image"

echo " Size: $FILE_SIZE bytes, Created: $CREATION_DATE"

fi

fi

done

echo "Scanning complete."

真实世界的示例与用例

示例 1:干扰犬类图像生成模型

研究者向训练集加入 50 张投毒狗图,模型输出出现畸形、多肢、卡通化等特征。当投毒样本增至 300 张时,模型生成的“狗”甚至呈现猫类特征。

示例 2:阻止艺术品被抓取

艺术家通过 Glaze + Nightshade 上传风景画,嵌入指纹式扰动。一旦被抓取用于训练,模型对自然风景的学习将被误导,输出难以还原真实艺术风格。

示例 3:超越艺术保护的网络安全应用

理解数据投毒机制有助于防御其他领域的投毒攻击,如自动驾驶、垃圾邮件检测、金融欺诈识别等。

法律与伦理影响

数据投毒工具同时带来机遇与风险。

艺术家权利

投毒可成为对 AI 公司不当抓取的威慑,促使其正当授权、付费或署名。

双刃剑困境

Nightshade 本是防御工具,却可能被恶意者滥用,攻击关键 AI 系统。因此需要网络安全社区制定防御与伦理准则。

负责任 AI 开发

Nightshade 的研究强化了“负责任 AI”话题。开发者需在创新与责任间取得平衡,确保训练数据来源合规。

数据安全与 AI 的未来方向

对抗鲁棒性进展

对抗训练、稳健优化及高级异常检测将帮助模型抵御投毒影响。

开源协作

开源推动社区审查和快速创新。更多人参与可加速工具和防御机制迭代。

与法律框架的融合

数据投毒工具可能影响未来版权法规,技术与政策或将趋于融合。

艺术家与技术人员的协作平台

诸如 Glaze + Nightshade 的平台为艺术家与技术人员架起桥梁,教育项目与研讨会将进一步促进跨界合作。

结论

Nightshade 重新定义了数据投毒与知识产权保护。通过让艺术家在作品被抓取前嵌入隐形扰动,Nightshade 不仅提供防御,还推动了有关 AI 伦理与法律责任的讨论。

本文阐述了数据投毒原理、Nightshade 的技术机制及网络安全影响,并给出了代码示例与实际用例,为艺术家与安全专家提供指南。

随着生成式 AI 不断进步,建立稳健且伦理的防护措施愈发重要。无论是保护数字艺术,还是保障关键系统安全,理解并利用 Nightshade 等技术将是实现公平数字生态的关键。

参考文献

- MIT Technology Review: This new data poisoning tool lets artists fight back against generative AI

- Usenix Security Conference

- Pillow 文档

- NumPy 文档

- OpenCV 文档

- SciPy 文档

- Introduction to Adversarial Machine Learning

在本文中,我们审视了艺术自由、网络安全与负责任 AI 开发之间的微妙平衡。通过了解 Nightshade 及类似数据投毒技术,跨行业利益相关者可更好地保护创意权利与 AI 系统完整性。持续的研究、协作与合理监管,将为 AI 的伦理创新与技术与艺术的相互尊重铺平道路。